Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

This is a detailed document describing HTTP/2 (RFC 7540), the background, concepts, protocol and something about existing implementations and what the future might hold.

See https://daniel.haxx.se/http2/ for the canonical home for this project.

See https://github.com/bagder/http2-explained for the source code of all book contents.

I encourage and welcome help and contributions from anyone who may have improvements to offer. We accept pull requests, but you can also just file issues or send email to [email protected] with your suggestions!

/ Daniel Stenberg

The http2 protocol mandates that a receiver must read and ignore all unknown frames (those with an unknown frame type). Two parties can negotiate the use of new frame types on a hop-by-hop basis, but those frames aren't allowed to change state and they will not be flow controlled.

The subject of whether http2 should allow extensions at all was debated at length during the protocol's development with opinions swinging for and against. After draft-12 the pendulum swung back one last time and extensions were ultimately allowed.

Extensions are not part of the actual protocol but will be documented outside of the core protocol spec. There are already two frame types that have been discussed for inclusion in the protocol that will probably be the first frames sent as extensions. I'll describe them here because of their popularity and previous state as “native” frames:

With the adoption of http2, there are reasons to suspect that TCP connections will be much lengthier and be kept alive much longer than HTTP 1.x connections have been. A client should be able to do a lot of what it wants with a single connection to each host/site, and that connection could potentially be open for quite some time.

This will affect how HTTP load balancers work and there may arise situations when a site wants to suggest that the client connect to another host. It could be for performance reasons, or if a site is being taken down for maintenance, etc.

The server will send the (or ALTSVC frame with http2) telling the client about an alternative service: another route to the same content, using another service, host, and port number.

A client should then attempt to connect to that service asynchronously and only use the alternative if the new connection succeeds.

The Alt-Svc header allows a server that provides content over http:// to inform the client that the same content is also available over a TLS connection.

This is a somewhat debatable feature. Such a connection would do unauthenticated TLS and wouldn't be advertized as “secure” anywhere, wouldn't use any padlock in the UI, and in fact there is no way to tell the user that it isn't plain old HTTP, but this is still opportunistic TLS and some people are very firmly against this concept.

A frame of this type is meant to be sent exactly once by an http2 party when it has data to send off but flow control forbids it to send any data. The idea is that if your implementation receives this frame you know you have messed up something and/or you're getting less than perfect transfer speeds.

A quote from draft-12, before this frame was moved out to become an extension:

“The BLOCKED frame is included in this draft version to facilitate experimentation. If the results of the experiment do not provide positive feedback, it could be removed”

This document describes http2 from a technical and protocol level. It started out as a presentation Daniel did in Stockholm in April 2014 that was subsequently converted and extended into a full-blown document with all details and proper explanations.

RFC 7540 is the official name of the final http2 specification and it was published on May 15th 2015: https://www.rfc-editor.org/rfc/rfc7540.txt

All and any errors in this document are my own and the results of my shortcomings. Please point them out and they will be fixed in updated versions.

In this document I've tried to consistently use the word "http2" to describe the new protocol while in pure technical terms, the proper name is HTTP/2. I made this choice for the sake of readability and to get a better flow in the language.

My name is Daniel Stenberg. I've been working with open source and networking for over twenty years in numerous projects. Possibly I'm best known for being the lead developer of curl and libcurl. I've been involved in the IETF HTTPbis working group for several years and there I've kept up-to-date with the refreshed HTTP 1.1 work as well as being involved in the http2 standardization work.

Email: [email protected]

Twitter:

Web:

Blog:

If you find mistakes, omissions, errors or blatant lies in this document, please send me a refreshed version of the affected paragraph and I'll make amended versions. I will give proper credits to everyone who helps out! I hope to make this document better over time.

This document is available at

This document is licensed under the Creative Commons Attribution 4.0 license:

The first version of this document was published on April 25th 2014. Here follows the largest changes in the most recent document versions.

Converted the master version of this document to Markdown syntax

13: Mention more resources, updated links and descriptions

12: Updated the QUIC description with reference to draft

8.5: Refreshed with current numbers

1.1: HTTP/2 is now in an official RFC

6.5.1: Link to the HPACK RFC

9.1: Mention the Firefox 36+ config switch for http2

12.1: Added section about QUIC

Lots of language improvements mostly pointed out by friendly contributors

8.3.1: Mention nginx and Apache httpd specific acitivities

1: The protocol has been “okayed”

4.1: Refreshed the wording since 2014 is last year

Front: Added image and call it “http2 explained” there, fixed link

1.4: Added document history section

Updated to HTTP/2 draft-17 and HPACK draft-11

Added section "10. http2 in Chromium" (== one page longer now)

Lots of spell fixes

At 30 implementations now

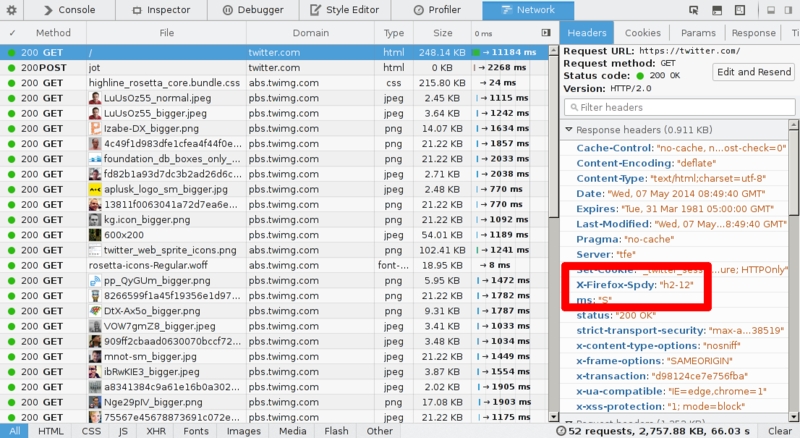

Firefox has been tracking the drafts very closely and has provided http2 test implementations for many months. During the development of the http2 protocol, clients and servers have to agree on what draft version of the protocol they implement which makes it slightly annoying to run tests. Just be aware so that your client and server agree on what protocol draft they implement.

In all Firefox versions starting with version 36, released Februrary 24th 2015, http2 is enabled by default.

Remember that Firefox only implements http2 over TLS. You will only ever see http2 in action with Firefox when going to https:// sites that offer http2 support.

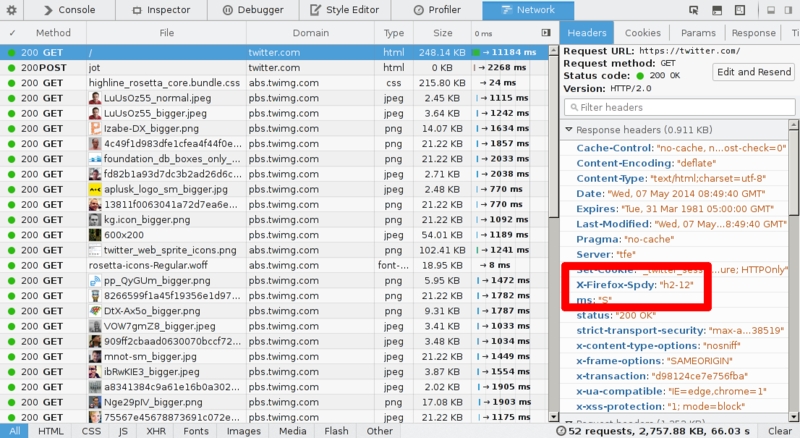

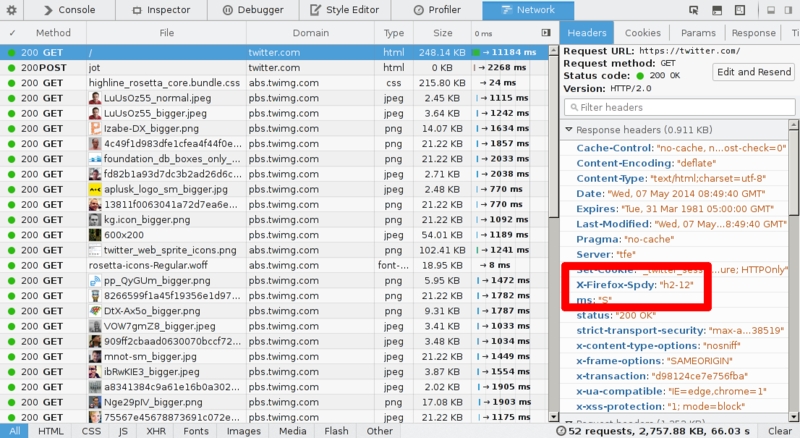

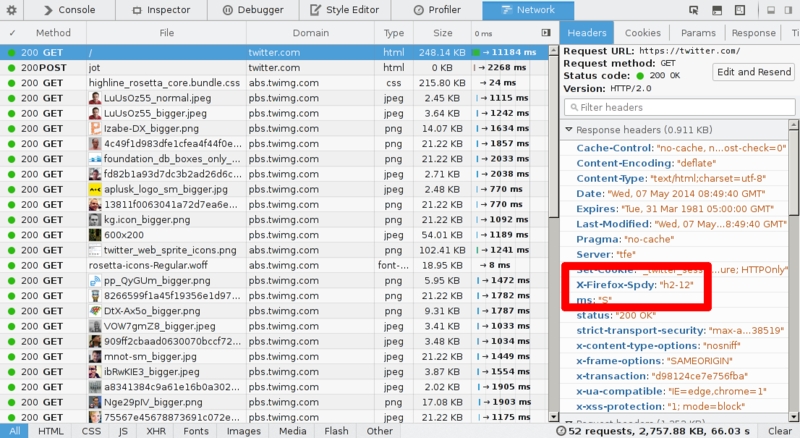

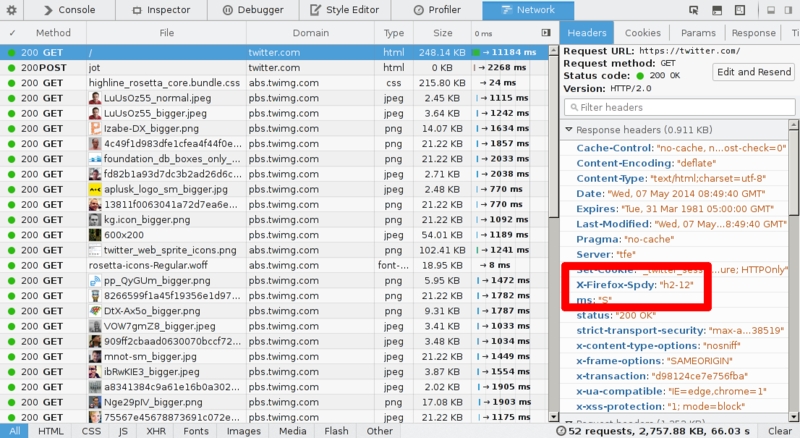

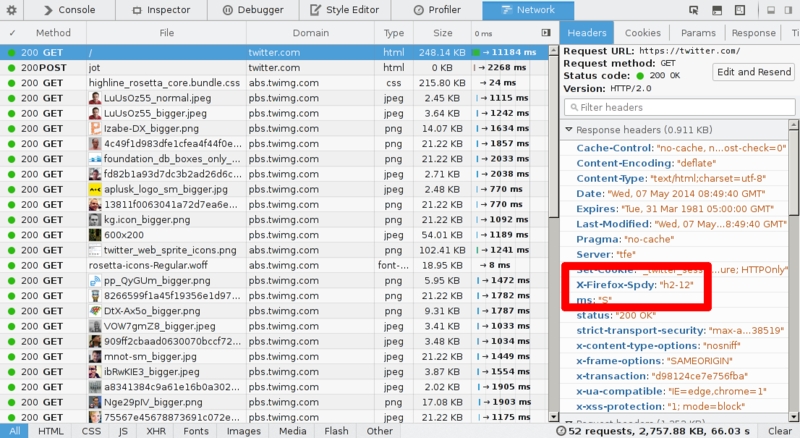

There is no UI element anywhere that tells that you're talking http2. You just can't tell that easily. One way to figure it out, is to enable “Web developer->Network” and check the response headers and see what you got back from the server. The response is then “HTTP/2.0” something and Firefox inserts its own header called “X-Firefox-Spdy:” as shown in the screenshot above.

The headers you see in the Network tool when talking http2 have been converted from http2's binary format into the old-style HTTP 1.x look-alike headers.

There are Firefox plugins available that help visualize if a site is using http2. One of them is .

If you think this document was a bit light on content or technical details, here are additional resources to help you satisfy your curiosity:

The HTTPbis mailing list and its archives: https://lists.w3.org/Archives/Public/ietf-http-wg/

The actual http2 specification in a HTMLified version: https://httpwg.github.io/specs/rfc7540.html

Firefox http2 networking details: https://wiki.mozilla.org/Networking/http2

curl http2 implementation details:

The http2 web site: and perhaps in particular the FAQ:

Ilya Grigorik's HTTP/2 chapter in his book “High Performance Browser Networking”:

A lot of tough decisions and compromises have been made for http2. With http2 getting deployed there is an established way to upgrade into other protocol versions that work which lays the foundation for doing more protocol revisions ahead. It also brings a notion and an infrastructure that can handle multiple different versions in parallel. Maybe we don't need to phase out the old entirely when we introduce new?

http2 still has a lot of HTTP 1 “legacy” brought with it into the future because of the desire to keep it possible to proxy traffic back and forth between HTTP 1 and http2. Some of that legacy hampers further development and inventions. Perhaps http3 can drop some of them?

What do you think is still lacking in http?

(This chapter was written in 2015, when QUIC was still in its early days. I have decided to leave it like this to give the reader a glimpse of how we viewed the future back then. See the next chapter for the 2022 take.)

Google's (Quick UDP Internet Connections) protocol is an interesting experiment, performed much in the same style and spirit as they did with SPDY. QUIC is a TCP + TLS + HTTP/2 replacement implemented using UDP.

QUIC allows the creation of connections with much less latency, it solves packet loss to only block individual streams instead of all of them like it does for HTTP/2 and it makes creating connections over different network interfaces easy - thus also covering areas MPTCP is meant to solve.

QUIC is so far only implemented by Google in Chrome and their server ends and that code is not easily re-used elsewhere, even if there's a effort trying exactly that. The protocol has been brought as a to the IETF transport working group.

QUIC is no longer an acronym. It is the name of a transport protocol that operates over UDP and is documented in four specifications: RFC 8999 to RFC 9002. Note that what is described in 12.1 above is the original Google QUIC protocol, and what is now made a standard is a different QUIC protocol even though the name has been kept.

HTTP/3 is the new HTTP version in progress. It is designed to work over the QUIC protocol.

For HTTP/3 and QUIC details, see .

HTTP 1.1 has turned into a protocol used for virtually everything on the Internet. Huge investments have been made in protocols and infrastructure that take advantage of this, to the extent that it is often easier today to make things run on top of HTTP rather than building something new on its own.

When HTTP was created and thrown out into the world, it was probably perceived as a rather simple and straightforward protocol, but time has proved that to be false. HTTP 1.0 in RFC 1945 is a 60-page specification released in 1996. RFC 2616 that describes HTTP 1.1 was released only three years later in 1999 and had grown significantly to 176 pages. Yet when we within IETF worked on the update to that spec, it was split up and converted into six documents with a much larger page count in total (resulting in RFC 7230 and family). By any count, HTTP 1.1 is big and includes a myriad of details, subtleties and, not the least, a lot of optional parts.

The Chromium team has implemented http2 and provided support for it in the dev and beta channel for a long time. Starting with Chrome 40, released on January 27th 2015, http2 is enabled by default for a certain amount of users. The amount started off really small and then increased gradually over time.

SPDY support was removed in Chrome 51 in favor of http2. In a blog post, the project announced in :

“Over 25% of resources in Chrome are currently served over HTTP/2, compared to less than 5% over SPDY. Based on such strong adoption, starting on May 15th — the anniversary of the HTTP/2 RFC — Chrome will no longer support SPDY.”

When faced with problems, people tend to gather to find workarounds. Some of the workarounds are clever and useful, but others are just awful kludges.

Spriting is the term often used to describe combining multiple small images to form a single larger image. Then, using JavaScript or CSS, you “cut out” pieces of that big image to show smaller individual ones.

A site would use this trick for speed. Getting a single big image in HTTP 1.1 is much faster than getting 100 smaller individual ones.

If you use a very old Chrome version you may want to check if the support is there.

Enter “chrome://flags/#enable-spdy4" in your browser's address bar and click “enable” if it isn't already showing it as enabled. This flag has been removed in recent version and the support is now always implied.

Remember that Chrome only implements http2 over TLS. You will only ever see http2 in action with Chrome when going to https:// sites that offer http2 support.

There are Chrome plugins available that helps visualize if a site is using HTTP/2. One of them is “HTTP/2 and SPDY Indicator”.

Chrome's current experiments with QUIC (see section 12.1) dilute the HTTP/2 numbers somewhat.

So what does http2 accomplish? Where are the boundaries for what the HTTPbis group set out to do?

The boundaries were actually quite strict and put many restraints on the team's ability to innovate:

http2 has to maintain HTTP paradigms. It is still a protocol where the client sends requests to the server over TCP.

http:// and https:// URLs cannot be changed. There can be no new scheme for this. The amount of content using such URLs is too big to expect them to change.

HTTP1 servers and clients will be around for decades, we need to be able to proxy them to http2 servers.

Subsequently, proxies must be able to map http2 features to HTTP 1.1 clients one-to-one.

Remove or reduce optional parts from the protocol. This wasn't really a requirement but more a mantra coming from SPDY and the Google team. By making sure everything is mandatory there's no way you can not implement anything now and fall into a trap later on.

No more minor version. It was decided that clients and servers are either compatible with http2 or they are not. If a need arises to extend the protocol or modify things, then http3 will be born. There are no more minor versions in http2.

As mentioned already, the existing URI schemes cannot be modified, so http2 must use the existing ones. Since they are used for HTTP 1.x today, we obviously need a way to upgrade the protocol to http2, or otherwise ask the server to use http2 instead of older protocols.

HTTP 1.1 has a defined way to do this, namely the Upgrade: header, which allows the server to send back a response using the new protocol when getting such a request over the old protocol, at the cost of an additional round-trip.

That round-trip penalty was not something the SPDY team would accept, and since they only implemented SPDY over TLS, they developed a new TLS extension which shortcuts the negotiation significantly. Using this extension, called NPN for Next Protocol Negotiation, the server tells the client which protocols it knows and the client can then use the protocol it prefers.

A lot of focus of http2 has been to make it behave properly over TLS. SPDY requires TLS and there's been a strong push for making TLS mandatory for http2, but it didn't get consensus so http2 shipped with TLS as optional. However, two prominent implementers have stated clearly that they will only implement http2 over TLS: the Mozilla Firefox lead and the Google Chrome lead, two of today's leading web browsers.

Reasons for choosing TLS-only include respect for user's privacy and early measurements showing that the new protocols have a higher success rate when done with TLS. This is because of the widespread assumption that anything that goes over port 80 is HTTP 1.1, which makes some middle-boxes interfere with or destroy traffic when any other protocols are used on that port.

The subject of mandatory TLS has caused much hand-wringing and agitated voices in mailing lists and meetings – is it good or is it evil? It is a highly controversial topic – be aware of this when you throw this question in the face of an HTTPbis participant!

Similarly, there's been a fierce and long-running debate about whether http2 should dictate a list of ciphers that should be mandatory when using TLS, or if it should perhaps blacklist a set, or if it shouldn't require anything at all from the TLS “layer” but leave that to the TLS working group. The spec ended up specifying that TLS should be at least version 1.2 and there are cipher suite restrictions.

Next Protocol Negotiation (NPN) is the protocol used to negotiate SPDY with TLS servers. As it wasn't a proper standard, it was taken through the IETF and the result was ALPN: Application Layer Protocol Negotiation. ALPN is being promoted for use by http2, while SPDY clients and servers still use NPN.

The fact that NPN existed first and ALPN has taken a while to go through standardization has led to many early http2 clients and http2 servers implementing and using both these extensions when negotiating http2. Also, NPN is what's used for SPDY and many servers offer both SPDY and http2, so supporting both NPN and ALPN on those servers makes perfect sense.

ALPN differs from NPN primarily in who decides what protocol to speak. With ALPN, the client gives the server a list of protocols in its order of preference and the server picks the one it wants, while with NPN the client makes the final choice.

As previously mentioned, for plain-text HTTP 1.1 the way to negotiate http2 is by presenting the server with an Upgrade: header. If the server speaks http2 it responds with a “101 Switching” status and from then on it speaks http2 on that connection. Of course this upgrade procedure costs a full network round-trip, but the upside is that it's generally possible to keep an http2 connection alive much longer and re-use it more than a typical HTTP1 connection.

While some browsers' spokespersons stated they will not implement this means of speaking http2, the Internet Explorer team once expressed that they would - although they have never delivered on that. curl and a few other non-browser clients support clear-text http2.

Today, no major browser supports http2 without TLS.

3.4: The average is now 40 TCP connections

6.4: Updated to reflect what the spec says

Many spelling and grammar mistakes corrected

14: Added thanks to bug reporters

2.4: Better labels for the HTTP growth graph

6.3: Corrected the wagon order in the multiplexed train

6.5.1: HPACK draft-12

8.5: Added some current usage numbers

8.3: Mention internet explorer too

8.3.1 Added "missing implementations"

8.4.3: Mention that TLS also increases success rate

HTTP 1.1's nature of having lots of tiny details and options available for later extensions has grown a software ecosystem where almost no implementation ever implements everything – and it isn't even really possible to exactly tell what “everything” is. This has led to a situation where features that were initially little-used saw very few implementations, and those that did implement the features then saw very little use of them.

Later on, this caused an interoperability problem when clients and servers started to increase the use of such features. HTTP pipelining is a primary example of such a feature.

HTTP 1.1 has a hard time really taking full advantage of all the power and performance that TCP offers. HTTP clients and browsers have to be very creative to find solutions that decrease page load times.

Other attempts that have been going on in parallel over the years have also confirmed that TCP is not that easy to replace, and thus we keep working on improving both TCP and the protocols on top of it.

Simply put, TCP can be utilized better to avoid pauses or wasted intervals that could have been used to send or receive more data. The following sections will highlight some of these shortcomings.

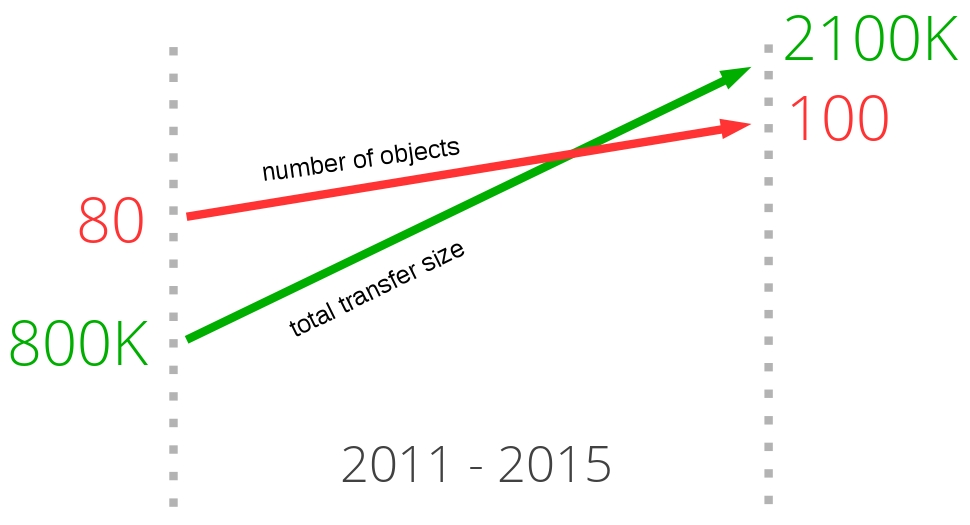

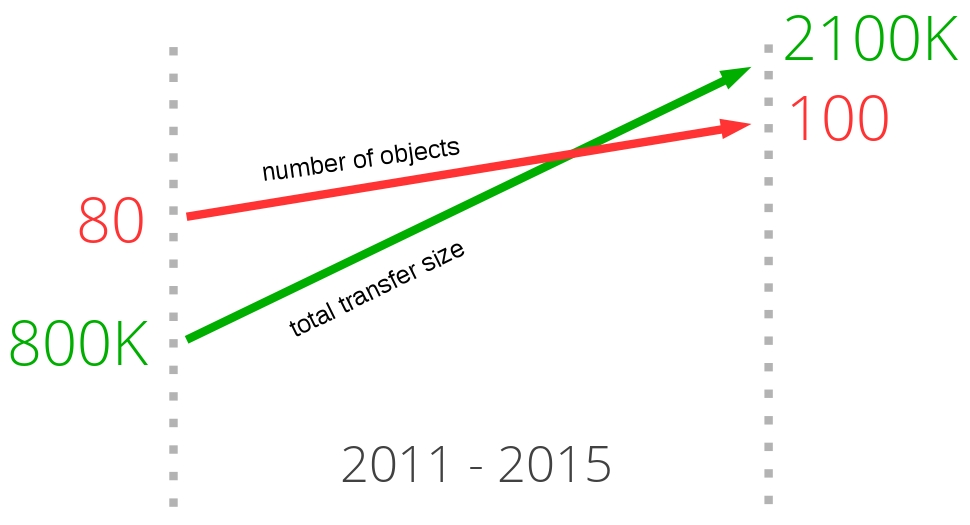

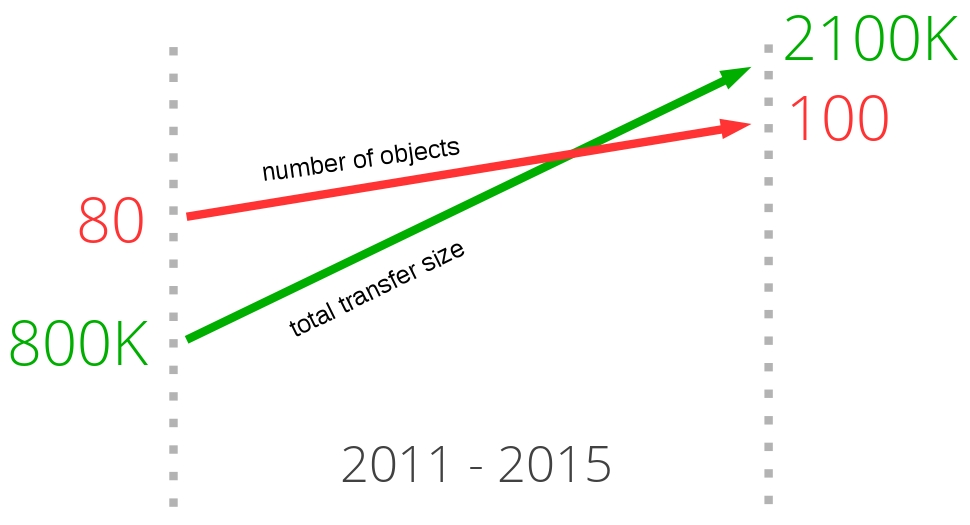

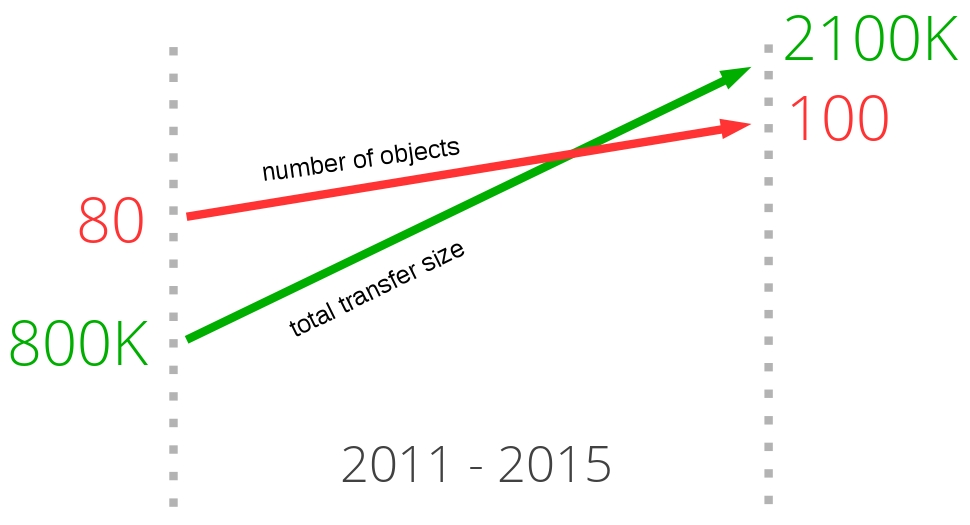

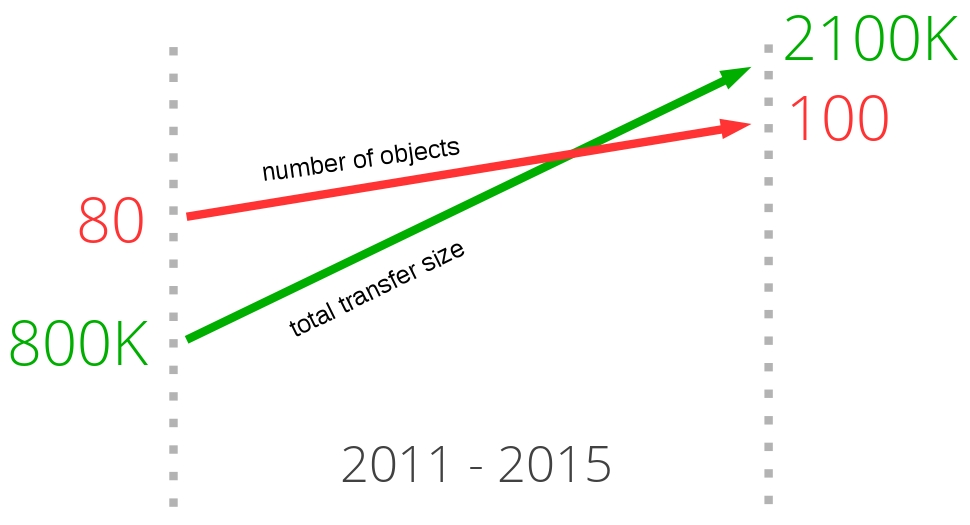

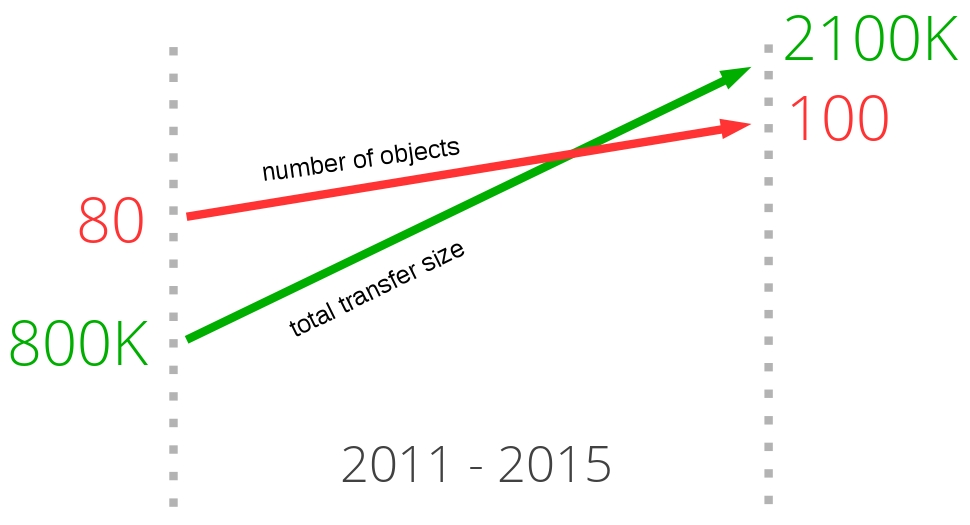

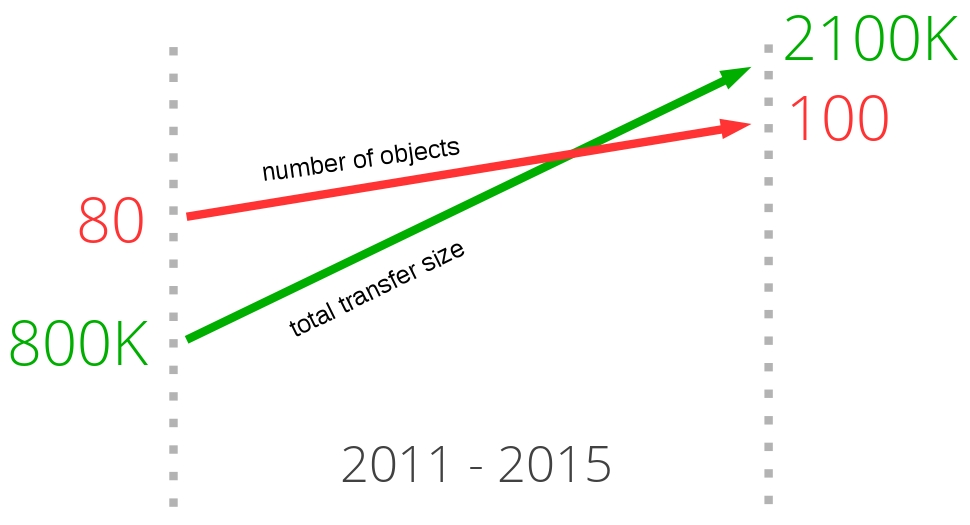

When looking at the trend for some of the most popular sites on the web today and what it takes to download their front pages, a clear pattern emerges. Over the years, the amount of data that needs to be retrieved has gradually risen up to and above 1.9MB. What is more important in this context is that, on average, over 100 individual resources are required to display each page.

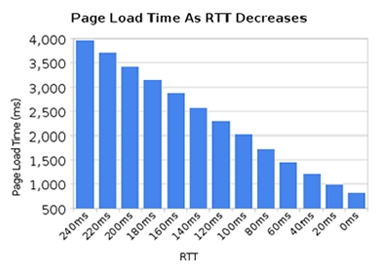

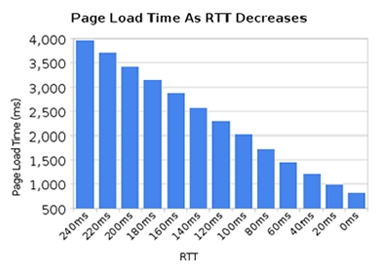

As the graph below shows, the trend has been going on for a while, and there is little to no indication that it will change anytime soon. It shows the growth of the total transfer size (in green) and the total number of requests used on average (in red) to serve the most popular web sites in the world, and how they have changed over the last four years.

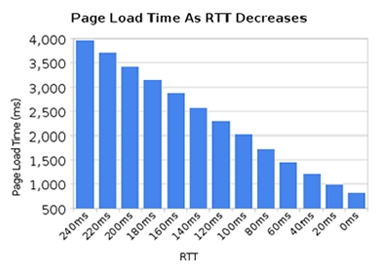

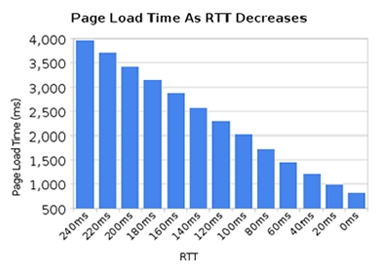

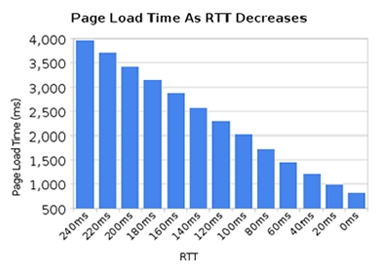

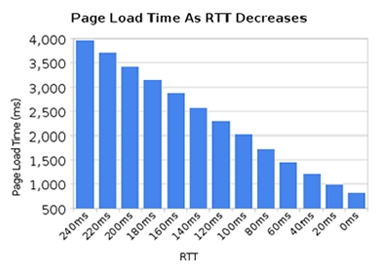

HTTP 1.1 is very latency sensitive, partly because HTTP pipelining is still riddled with enough problems to remain switched off to a large percentage of users.

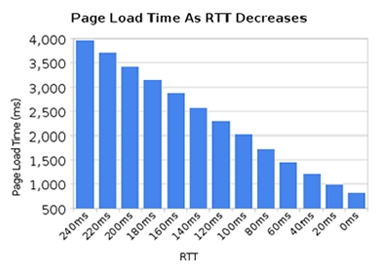

While we've seen a great increase in available bandwidth to people over the last few years, we have not seen the same level of improvements in reducing latency. High-latency links, like many of the current mobile technologies, make it hard to get a good and fast web experience even if you have a really high bandwidth connection.

Another use case requiring low latency is certain kinds of video, like video conferencing, gaming and similar where there's not just a pre-generated stream to send out.

HTTP pipelining is a way to send another request while waiting for the response to a previous request. It is very similar to queuing at a counter at the bank or in a supermarket: you just don't know if the person in front of you is a quick customer or that annoying one that will take forever before he/she is done. This is known as head-of-line blocking.

Sure, you can attempt to pick the line you believe is the correct one, and at times you can even start a new line of your own. But in the end, you can't avoid making a decision. And once it is made, you cannot switch lines.

Creating a new line is also associated with a performance and resource penalty, so that's not scalable beyond a smaller number of lines. There's just no perfect solution to this.

Even today, most desktop web browsers ship with HTTP pipelining disabled by default.

Additional reading on this subject can be found in the Firefox bugzilla entry 264354.

Inlining is another trick used to avoid sending individual images, and this is done by using data URLs embedded in the CSS file. This has similar benefits and drawbacks as the spriting case.

A big site can end up with a lot of different JavaScript files. Developers can use front-end tools to concatenate, or combine, multiple scripts so that the browser will get a single big file instead of dozens of smaller ones. Too much data is sent when only little is needed and, likewise, too much data needs to be reloaded when a change is made.

This practice is, of course, mostly an inconvenience to the developers involved.

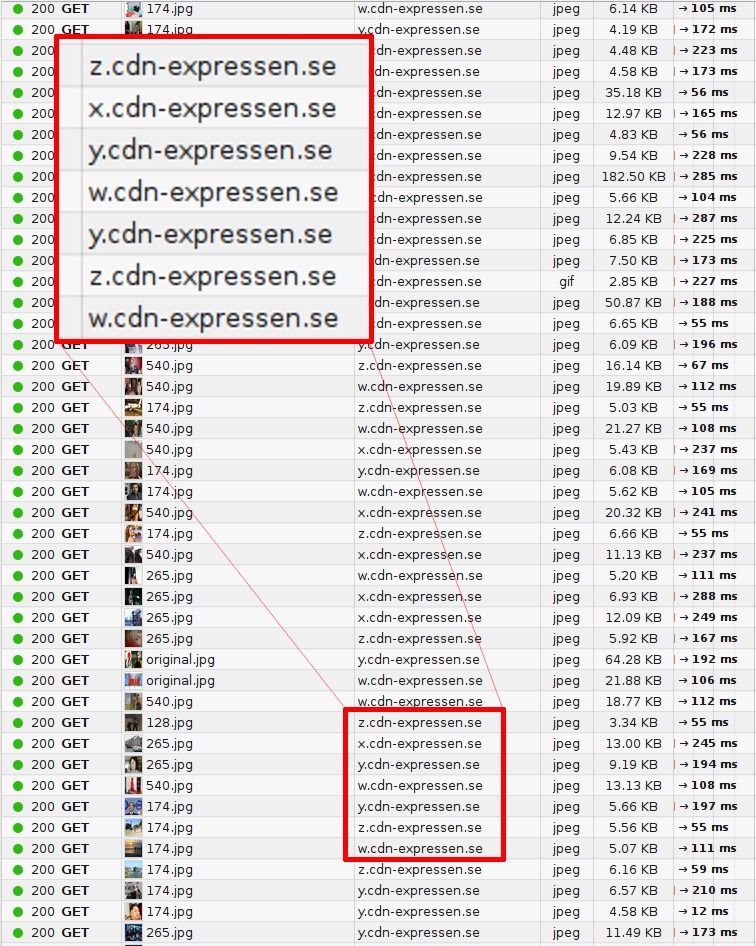

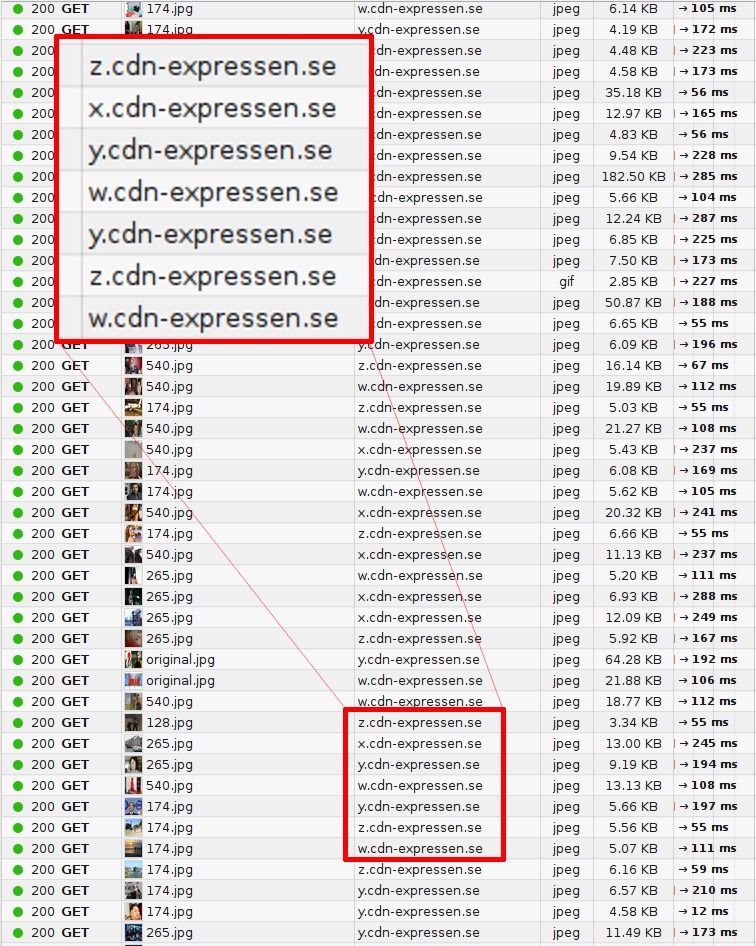

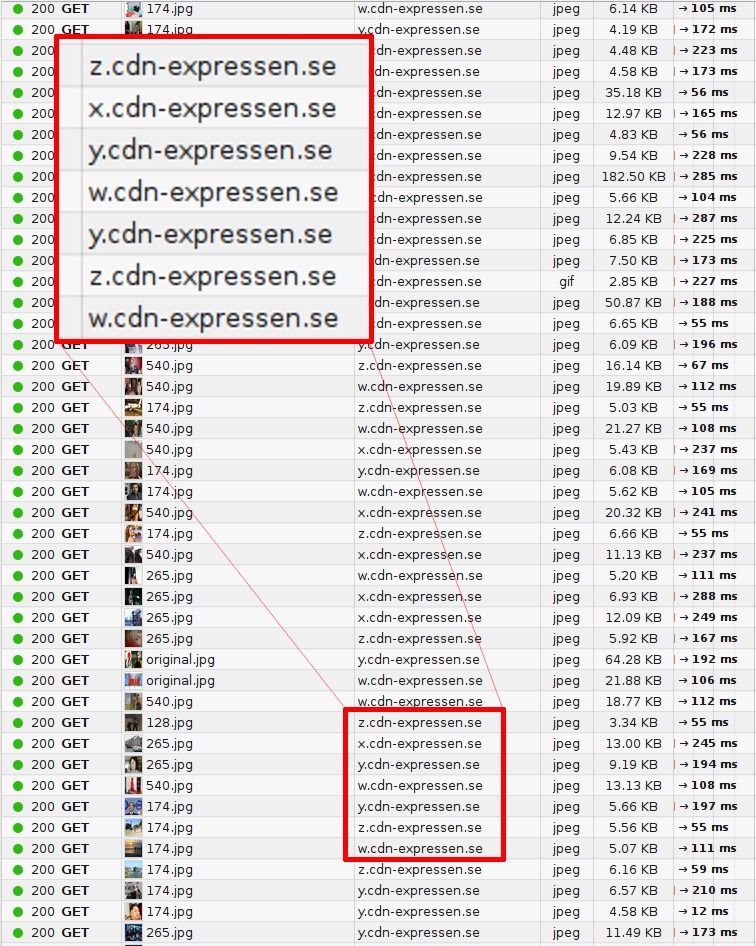

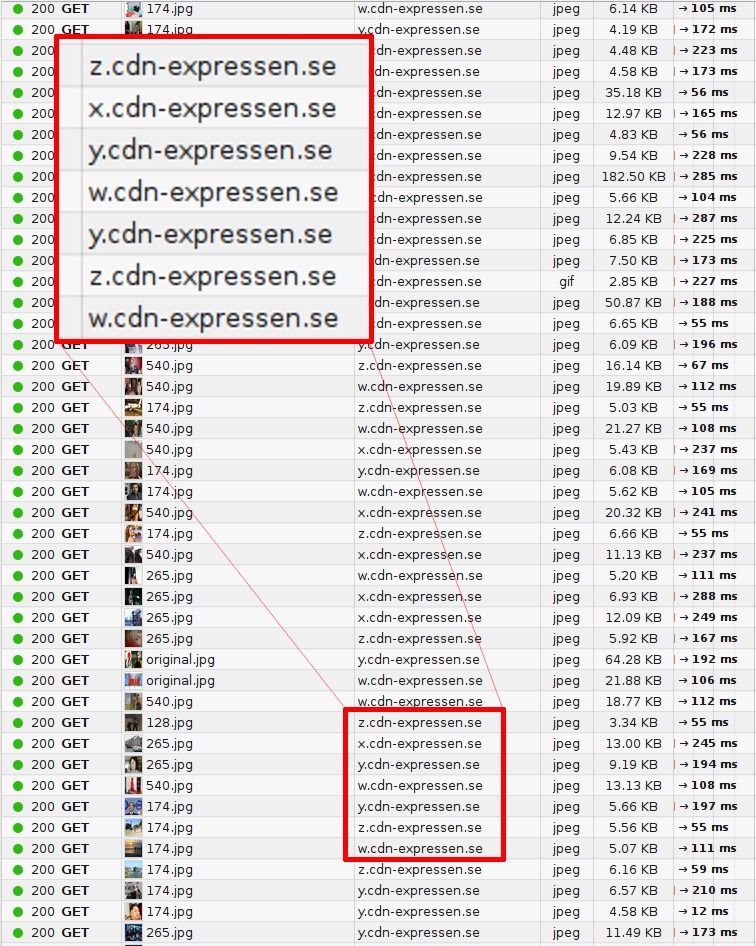

The final performance trick I'll mention is often referred to as “sharding.” It basically means serving aspects of your service on as many different hosts as possible. At first glance this seems strange, but there is sound reasoning behind it.

Initially, the HTTP 1.1 specification stated that a client was allowed to use a maximum of two TCP connections for each host. So, in order to not violate the spec, clever sites simply invented new host names and – voilà – you could get more connections to your site and decreased page load times.

Over time that limitation was removed, and today clients easily use six to eight connections per host name. But they still have a limit, so sites continue to use this technique to bump up the number of connections. As the number of objects requested over HTTP is ever-increasing – as I showed before – the large number of connections is then used to make sure HTTP performs well and allow your site to load quickly. It is not unusual for sites to use well over 50 or even up to 100 or more connections now for a single site using this technique. Recent stats from httparchive.org show that the top 300K URLs in the world need, on average, 40(!) TCP connections to display the site, and the trend says this is still increasing slowly over time.

Another reason for sharding is to put images or similar resources on a separate host name that doesn't use any cookies, as the size of cookies these days can be quite significant. By using cookie-free image hosts, you can sometimes increase performance simply by allowing much smaller HTTP requests!

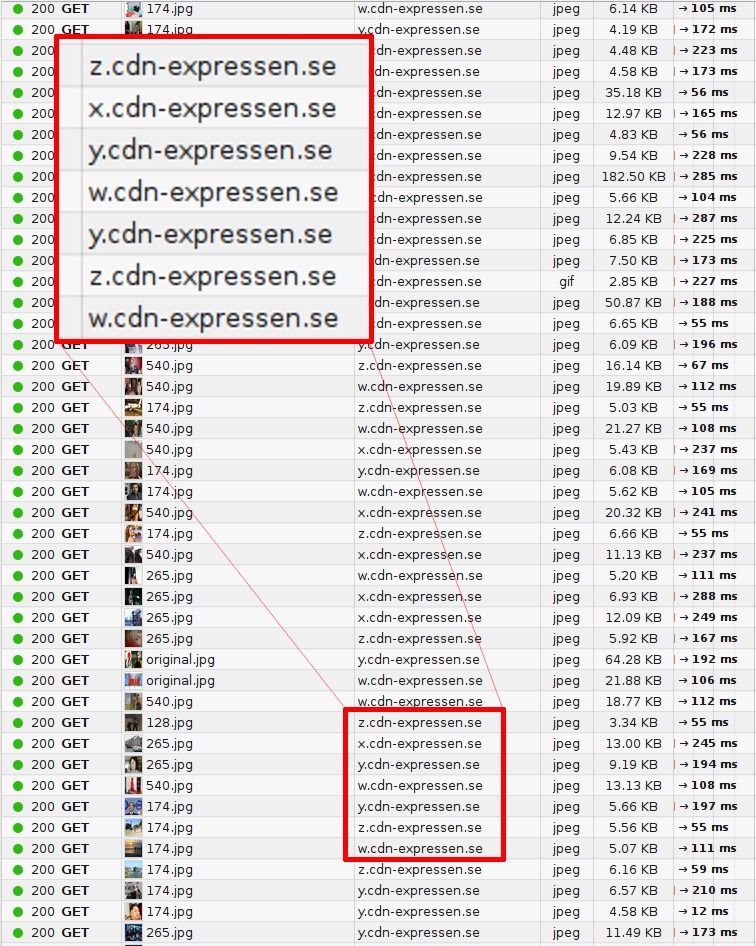

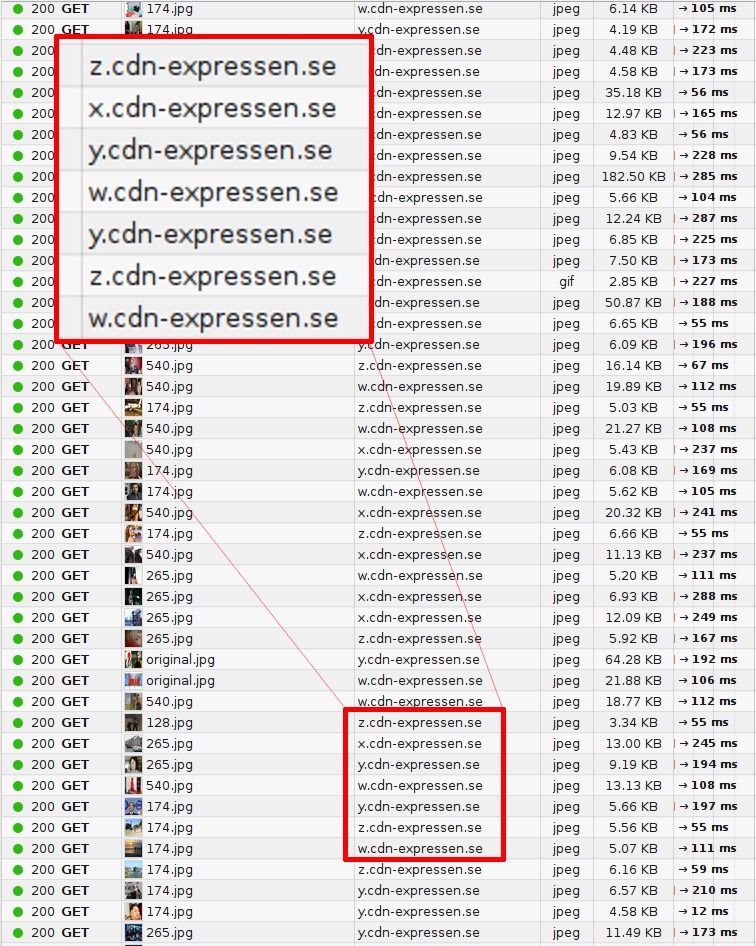

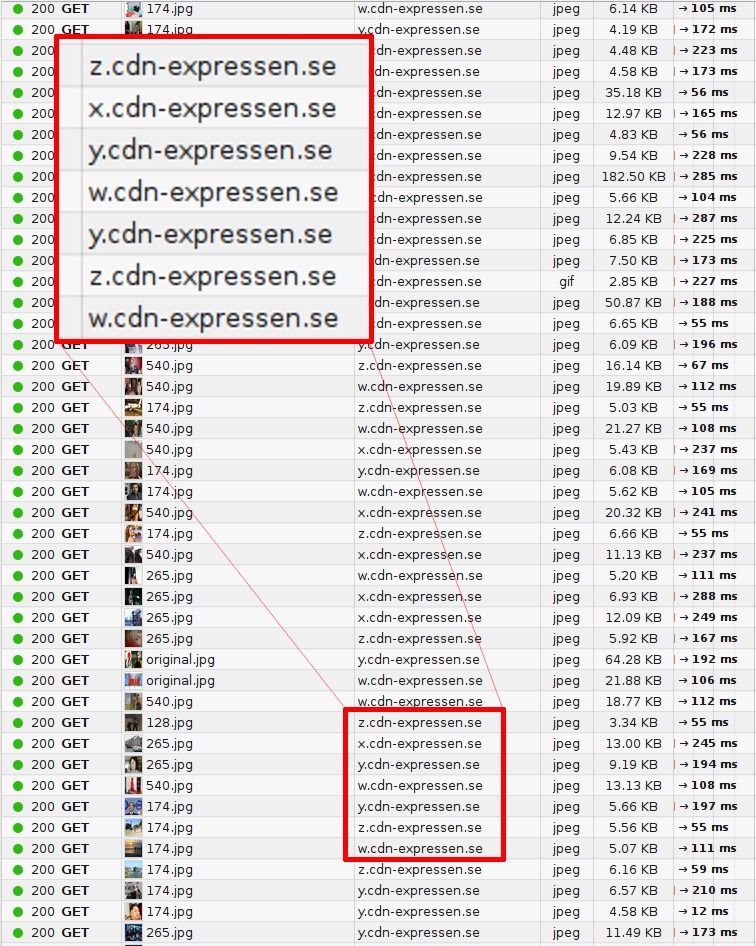

The image below shows what a packet trace looks like when browsing one of Sweden's top web sites and how requests are distributed over several host names.

The curl project has been providing experimental http2 support since September 2013.

In the spirit of curl, we intend to support just about every aspect of http2 that we possibly can. curl is often used as a test tool and tinkerer's way to poke on web sites and we intend to keep that up for http2 as well.

curl uses the separate library nghttp2 for the http2 frame layer functionality. curl requires nghttp2 1.0 or later.

Note that currently on linux curl and libcurl are not always delivered with HTTP/2 protocol support enabled.

Internally, curl will convert incoming http2 headers to HTTP 1.x style headers and provide them to the user, so that they will appear very similar to existing HTTP. This allows for an easier transition for whatever is using curl and HTTP today. Similarly curl will convert outgoing headers in the same style. Give them to curl in HTTP 1.x style and it will convert them on the fly when talking to http2 servers. This also allows users to not have to bother or care very much with which particular HTTP version that is actually used on the wire.

curl supports http2 over standard TCP via the Upgrade: header. If you do an HTTP request and ask for HTTP 2, curl will ask the server to update the connection to http2 if possible.

curl supports a wide range of different TLS libraries for its TLS back-end, and that is still valid for http2 support. The challenge with TLS for http2's sake is the ALPN support and to some extent NPN support.

Build curl against modern versions of OpenSSL or NSS to get both ALPN and NPN support. Using GnuTLS or PolarSSL you will get ALPN support but not NPN.

To tell curl to use http2, either plain text or over TLS, you use the --http2 option (that is “dash dash http2”). curl defaults to HTTP/1.1 for HTTP: URLs so the extra option is necessary when you want http2 for that. For HTTPS URLs, curl will attempt to use http2.

Your application would use https:// or http:// URLs like normal, but you set curl_easy_setopt's CURLOPT_HTTP_VERSION option to CURL_HTTP_VERSION_2 to make libcurl attempt to use http2. It will then do a best effort and do http2 if it can, but otherwise continue to operate with HTTP 1.1.

As libcurl tries to maintain existing behaviors to a far extent, you need to enable HTTP/2 multiplexing for your application with the option. Otherwise it will continue using one request at a time per connection.

Another little detail to keep in mind is that if you ask for several transfers at once with libcurl, using its multi interface, an application can very well start any number of transfers at once and if you then rather have libcurl wait a little to add them all over the same connection rather than opening new connections for all of them at once, you use the option for each individual transfer you rather wait.

libcurl 7.44.0 and later supports HTTP/2 server push. You can take advantage of this feature by setting up a push callback with the option. If the push is accepted by the application, it'll create a new transfer as an CURL easy handle and deliver content on it, just like any other transfer.

Wouldn't it be nice to make an improved protocol? It would...

Be less latency sensitive

Fix pipelining and the head of line blocking problem

Eliminate the need to keep increasing the number of connections to each host

Keep all existing interfaces, all content, the URI formats and schemes

Be made within the IETF's HTTPbis working group

The Internet Engineering Task Force (IETF) is an organization that develops and promotes internet standards, mostly on the protocol level. They're widely known for the RFC series of memos documenting everything from TCP, DNS, and FTP, to best practices, HTTP, and numerous protocol variants that never went anywhere.

Within IETF, dedicated “working groups” are formed with a limited scope to work toward a goal. They establish a “charter” with some set guidelines and limitations for what they should produce. Everyone and anyone is allowed to join in the discussions and development. Everyone who attends and says something has the same weight and chance to affect the outcome and everyone is counted as an individual, with little regard to which company they work for.

The HTTPbis working group (see later for an explanation of the name) was formed during the summer of 2007 and tasked with creating an update of the HTTP 1.1 specification. Within this group the discussions about a next-version HTTP really started during late 2012. The HTTP 1.1 updating work was completed early 2014 and resulted in the series.

The final inter-op meeting for the HTTPbis WG was held in New York City in the beginning of June 2014. The remaining discussions and the IETF procedures performed to actually get the official RFC out continued into the following year.

Some of the bigger players in the HTTP field have been missing from the working group discussions and meetings. I don't want to mention any particular company or product names here, but clearly some actors on the Internet today seem to be confident that IETF will do good without these companies being involved...

The group is named HTTPbis where the "bis" part comes from the . Bis is commonly used as a suffix or part of the name within the IETF for an update or the second take on a spec; in this case, the update to HTTP 1.1.

is a protocol that was developed and spearheaded by Google. They certainly developed it in the open and invited everyone to participate but it was obvious that they benefited by being in control over both a popular browser implementation and a significant server population with well-used services.

When the HTTPbis group decided it was time to start working on http2, SPDY had already proven that it was a working concept. It had shown it was possible to deploy on the Internet and there were published numbers that proved how well it performed. The http2 work began with the SPDY/3 draft that was basically made into the http2 draft-00 with a little search and replace.

Inspiración y la imagen del paquete con formato Lego de Mark Nottingham.

Los datos de tendencias HTTP vienen de .

El gráfico RTT viene de las presentaciones hechas por Mike Belshe.

A mis hijos Agnes y Rex por prestarme sus figuritas Lego para la imagen de “head of line”.

Gracias a los siguientes amigos por las revisiones y el feedback: Kjell Ericson, Bjorn Reese, Linus Swälas and Anthony Bryan. Se aprecia mucho vuestra ayuda que ¡ha mejorado de verdad este documento!

Durante varias iteraciones, las siguientes personas han reportado bugs y sugerido mejoras al documento: Mikael Olsson, Remi Gacogne, Benjamin Kircher, saivlis, florin-andrei-tp, Brett Anthoine, Nick Parlante, Matthew King, Nicolas Peels, Jon Forrest, sbrickey, Marcin Olak, Gary Rowe, Ben Frain, Mats Linander, Raul Siles, Alex Lee, Richard Moore

El traductor a español, Javier Infante, quisiera agradecer a Gorka Gorrotxategi por la revisión y sus correcciones sobre este texto.

.icon1 {

background: url(data:image/png;base64,<data>) no-repeat;

}

.icon2 {

background: url(data:image/png;base64,<data>) no-repeat;

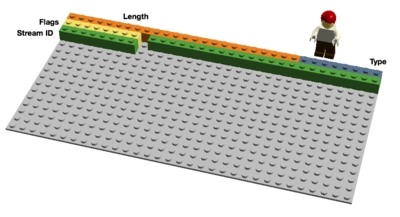

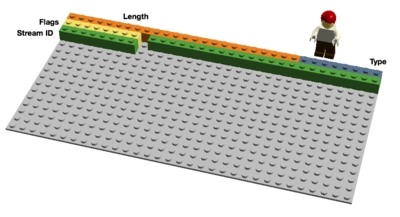

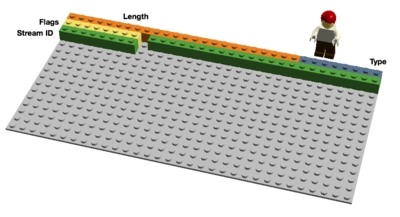

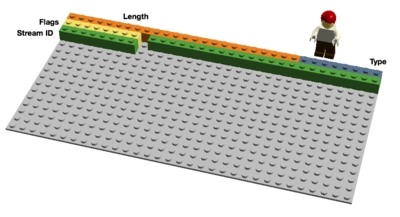

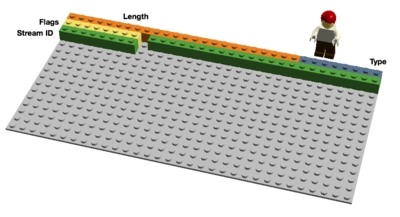

}Inspiration and the package format Lego image from Mark Nottingham.

HTTP trend data comes from https://httparchive.org/.

The RTT graph comes from presentations done by Mike Belshe.

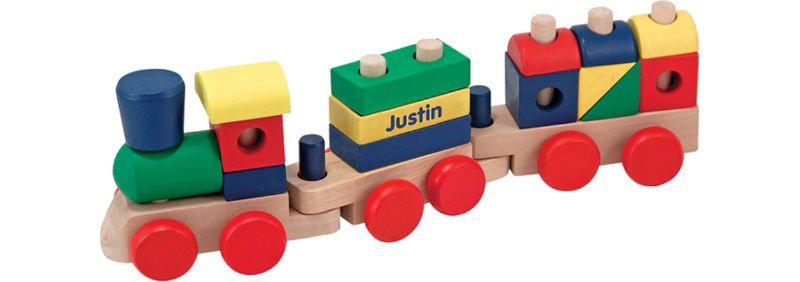

My kids Agnes and Rex for letting me borrow their Lego figures for the head of line picture.

Thanks to the following friends for reviews and feedback: Kjell Ericson, Bjorn Reese, Linus Swälas and Anthony Bryan. Your help is greatly appreciated and has really improved the document!

During the various iterations, the following friendly people have provided bug reports and improvements to the document: Mikael Olsson, Remi Gacogne, Benjamin Kircher, saivlis, florin-andrei-tp, Brett Anthoine, Nick Parlante, Matthew King, Nicolas Peels, Jon Forrest, sbrickey, Marcin Olak, Gary Rowe, Ben Frain, Mats Linander, Raul Siles, Alex Lee, Richard Moore

L'inspiration et l'assemblage Lego : Mark Nottingham

Les tendances HTTP : https://httparchive.org/

Le graphique RTT (Aller-Retour) vient des présentations de Mike Belshe.

Mes enfants Agnès et Rex pour m'avoir prêté leurs Lego.

Merci à mes amis pour les relectures et commentaires : Kjell Ericson, Bjorn Reese, Linus Swalas et Anthony Bryan. Votre aide est appréciée et a réellement amélioré ce document!

Pendant les diverses itérations du document, les personnes suivantes ont fourni ou suggéré des améliorations: Mikael Olsson, Remi Gacogne, Benjamin Kircher, saivlis, florinandrei-tp, Brett Anthoine, Nick Parlante, Matthew King, Nicolas Peels, Jon Forrest, sbrickey, Marcin Olak, Gary Rowe, Ben Frain, Mats Linander, Raul Sile, Alex Lee et Richard Moore.

Le traducteur de cette version française, Olivier Cahagne, souhaite remercier Luc Trudeau, Mehdi Achour, Pascal Borreli et Remi Gacogne pour leurs relectures, nombreuses corrections et suggestions.

(번역되지 않은)

(번역되지 않은)

(번역되지 않은)

Enough about the background, the history and politics behind what got us here. Let's dive into the specifics of the protocol: the bits and the concepts that make up http2.

http2 is a binary protocol.

Just let that sink in for a minute. If you've been involved in internet protocols before, chances are that you will now be instinctively reacting against this choice, marshaling your arguments that spell out how protocols based on text/ascii are superior because humans can handcraft requests over telnet and so on...

http2 is binary to make the framing much easier. Figuring out the start and the end of frames is one of the really complicated things in HTTP 1.1 and, actually, in text-based protocols in general. By moving away from optional white space and different ways to write the same thing, implementation becomes simpler.

Also, it makes it much easier to separate the actual protocol parts from the framing - which in HTTP1 is confusingly intermixed.

The fact that the protocol features compression and will often run over TLS also diminishes the value of text, since you won't see text over the wire anyway. We simply have to get used to the idea of using something like a Wireshark inspector to figure out exactly what's going on at the protocol level in http2.

Debugging this protocol will probably have to be done with tools like curl, or by analyzing the network stream with Wireshark's http2 dissector and similar.

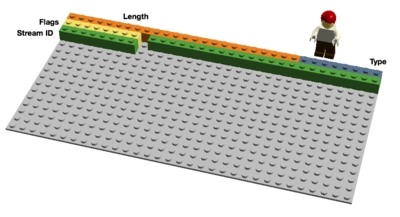

http2 sends binary frames. There are different frame types that can be sent and they all have the same setup: Length, Type, Flags, Stream Identifier, and frame payload.

There are ten different frame types defined in the http2 spec and perhaps the two most fundamental ones that map to HTTP 1.1 features are DATA and HEADERS. I'll describe some of the frames in more detail further on.

The Stream Identifier mentioned in the previous section associates each frame sent over http2 with a “stream”. A stream is an independent, bi-directional sequence of frames exchanged between the client and server within an http2 connection.

A single http2 connection can contain multiple concurrently-open streams, with either endpoint interleaving frames from multiple streams. Streams can be established and used unilaterally or shared by either the client or server and they can be closed by either endpoint. The order in which frames are sent within a stream is significant. Recipients process frames in the order they are received.

Multiplexing the streams means that packages from many streams are mixed over the same connection. Two (or more) individual trains of data are made into a single one and then split up again on the other side. Here are two trains:

The two trains multiplexed over the same connection:

Each stream also has a priority (also known as “weight”), which is used to tell the peer which streams to consider most important, in case there are resource restraints that force the server to select which streams to send first.

Using the PRIORITY frame, a client can also tell the server which other stream this stream depends on. It allows a client to build a priority “tree” where several “child streams” may depend on the completion of “parent streams”.

The priority weights and dependencies can be changed dynamically at run-time, which should enable browsers to make sure that when users scroll down a page full of images, the browser can specify which images are most important, or if you switch tabs it can prioritize a new set of streams that suddenly come into focus.

HTTP is a stateless protocol. In short, this means that every request needs to bring with it as much detail as the server needs to serve that request, without the server having to store a lot of info and meta-data from previous requests. Since http2 doesn't change this paradigm, it has to work the same way.

This makes HTTP repetitive. When a client asks for many resources from the same server, like images from a web page, there will be a large series of requests that all look almost identical. A series of almost identical somethings begs for compression.

While the number of objects per web page has increased (as mentioned earlier), the use of cookies and the size of the requests have also kept growing over time. Cookies also need to be included in all requests, often the same ones in multiple requests.

The HTTP 1.1 request sizes have actually gotten so large that they sometimes end up larger than the initial TCP window, which makes them very slow to send as they need a full round-trip to get an ACK back from the server before the full request has been sent. This is another argument for compression.

HTTPS and SPDY compression were found to be vulnerable to the and attacks. By inserting known text into the stream and figuring out how that changes the output, an attacker can figure out what's being sent in an encrypted payload.

Doing compression on dynamic content for a protocol - without becoming vulnerable to one of these attacks - requires some thought and careful consideration. This is what the HTTPbis team tried to do.

Enter , Header Compression for HTTP/2, which – as the name suggests - is a compression format especially crafted for http2 headers, and it is being specified in a separate internet draft. The new format, together with other counter-measures (such as a bit that asks intermediaries to not compress a specific header and optional padding of frames), should make it harder to exploit compression.

In the words of Roberto Peon (one of the creators of HPACK):

“HPACK was designed to make it difficult for a conforming implementation to leak information, to make encoding and decoding very fast/cheap, to provide for receiver control over compression context size, to allow for proxy re-indexing (i.e., shared state between frontend and backend within a proxy), and for quick comparisons of Huffman-encoded strings”.

One of the drawbacks with HTTP 1.1 is that when an HTTP message has been sent off with a Content-Length of a certain size, you can't easily just stop it. Sure, you can often (but not always) disconnect the TCP connection, but that comes at the cost of having to negotiate a new TCP handshake again.

A better solution would be to just stop the message and start anew. This can be done with http2's RST_STREAM frame which will help prevent wasted bandwidth and the need to tear down connections.

This is the feature also known as “cache push”. The idea is that if the client asks for resource X, the server may know that the client will probably want resource Z as well, and sends it to the client without being asked. It helps the client by putting Z into its cache so that it will be there when it wants it.

Server push is something a client must explicitly allow the server to do. Even then, the client can swiftly terminate a pushed stream at any time with RST_STREAM should it not want a particular resource.

Each individual http2 stream has its own advertised flow window that the other end is allowed to send data for. If you happen to know how SSH works, this is very similar in style and spirit.

For every stream, both ends have to tell the peer that it has enough room to handle incoming data, and the other end is only allowed to send that much data until the window is extended. Only DATA frames are flow controlled.

Firefox a suivi les drafts de près et fourni des protocoles de test de http2 depuis des mois. Pendant le développement du protocole http2, les clients et serveurs devaient s'accorder sur le draft du protocole à utiliser, ce qui compliquait les tests. Soyez juste conscient de vous mettre d'accord sur le draft à utiliser entre client et serveur.

Toute version de Firefox 35 et ultérieure, depuis le 13 janvier 2015, a le support http2 activé par défaut.

Allez dans "about:config" depuis la barre d'URL et cherchez l'option appelée "network.http.spdy.enabled.http2draft". Assurez-vous qu'elle est à "true". Firefox 36 ajouta une option activée par défaut "network.http.spdy.enabled.http2". Cette dernière contrôle la version finale de http2 tandis que la première active ou non la négociation des versions drafts de http2. Les deux sont activées depuis Firefox 36.

Souvenez-vous que Firefox n'implémente http2 que sur TLS. Vous ne verrez du http2 que si vous allez sur les sites https:// qui offrent http2.

Il n'y a pas d'indication graphique que vous utilisez http2. Vous ne pouvez pas le voir facilement. Une manière de le trouver est d'activer "Web developer->Network" et de vérifier l'en-tête de réponse. Elle doit comporter "HTTP/2.0", Firefox insère son propre entête "X-Firefox-Spdy:" comme montré sur la copie d'écran précédente.

Les en-têtes que vous voyez dans l'outil ont été convertis du format binaire http2 vers un format qui ressemble aux en-têtes HTTP 1.x.

Il existe des plug-ins Firefox permettant de visualiser si un site utilise http2. En voici un .

Si vous pensez que ce document était léger en contenu ou détails techniques, voici quelques ressources pour satisfaire votre curiosité:

La mailing-list HTTPbis et ses archives : https://lists.w3.org/Archives/Public/ietf-http-wg/

La spécification http2 au format HTML : https://httpwg.github.io/specs/rfc7540.html

Les aspects réseaux http2 de Firefox : https://wiki.mozilla.org/Networking/http2

Détail d'implémentation http2 dans curl :

Les sites web http2: et en particulier la FAQ :

Le chapitre de Ilya Grigorik sur HTTP/2 dans son livre “High Performance Browser Networking”:

A lot of tough decisions and compromises have been made for http2. With http2 getting deployed there is an established way to upgrade into other protocol versions that work which lays the foundation for doing more protocol revisions ahead. It also brings a notion and an infrastructure that can handle multiple different versions in parallel. Maybe we don't need to phase out the old entirely when we introduce new?

http2 ha a che fare con un sacco di eredità di HTTP 1, per via del fatto che si è voluto poter lasciare aperta la possibilità di proxificare avanti e indietro il traffico HTTP 1 e http2. Parte di questa eredità pone un limite a futuri sviluppi e invenzioni. Magari http3 potrà disfarsi di questa eredità ?

Cosa pensate che possa ancora mancare a http?

Il protocollo di Google (Quick UDP Internet Connections) è un esperimento interessante che si è svolto in linea con lo stesso spirito e stile di SPDY. QUIC è un rimpiazzo per TCP + TLS + HTTP/2 implementato su UDP.

QUIC permette la creazione di connessioni con minor latenza, risolve la perdita di pacchetti bloccando individualmente uno stream piuttosto che tutti insieme come avviene in HTTP/2, olre a rendere possibile un muliplex semplificato su NIC diversi - coprendo quindi aree relative a ciò che MPTCP dovrebbe risolvere.

QUIC è per il momento implementato solo dai server di Google e dal loro browser Chrome; tale codice non è facilmente riutilizzabile altrove, anche se esiste una libreria che cerca di provvedere alla lacuna . Il protocollo è stato presentato al gruppo di lavoro "transport" dela IETF nella draft .

Plusieurs décisions et compromis sont intervenus pour concevoir http2. Avec http2 en cours de déploiement, on a un moyen éprouvé de mise à niveau de version de protocole, qui permettra le développement d'autres révisions de protocoles. Cela montre aussi qu'une même infrastructure peut supporter plusieurs versions de protocole en parallèle. Peut-être pouvons-nous garder l'ancien protocole une fois le nouveau mis en place ?

http2 a pas mal de principes hérités de HTTP 1 pour qu'il soit possible de proxifier du trafic entre HTTP 1 et http2. Certains principes freinent le développement et l'innovation. Peut-être http3 pourra-t-il passer outre ces principes ?

Que pensez-vous qu'il manque à http ?

Le protocole QUIC (Quick UDP Internet Connections) de Google est une expérimentation très intéressante, menée dans le même esprit que SPDY. QUIC est un substitut à TCP + TLS + HTTP/2 implémenté avec UDP.

QUIC permet la création de connexions avec moins de latence, il résout la perte de paquet en ne bloquant qu'un flux particulier au lieu de tous les flux en HTTP/2 et il permet d'établir des connexions à travers différentes interfaces réseau, et du coup, couvre des problématiques que MPTCP résout.

QUIC est pour l'instant uniquement disponible à travers Chrome et les serveurs Google et le code n'est pas facilement réutilisable, même s'il existe une pour ce faire justement. Le protocole a été soumis en tant que à l'IETF transport working group.

Se pensate che questo documento sia ancora troppo poco tecnico, qui troverete altre risorse per soddisfare la vostra curiosità:

La mailing list e gli archivi di HTTPbis: https://lists.w3.org/Archives/Public/ietf-http-wg/

La specifica http2 odierna in una versione HTMLified: https://httpwg.github.io/specs/rfc7540.html

Dettagli sul networking http2 di Firefox http2: https://wiki.mozilla.org/Networking/http2

Dettagli sulla implementazione di http2 in curl:

Il sito di http2: e più in particolare la FAQ:

Il capitolo di Ilya Grigorik's su HTTP/2 nel suo libro “High Performance Browser Networking”:

تیم کرومیوم http2 را پیادهسازی کردهاند و پشتیبانی نیز برای آن ارائه میدهند. از کروم ۴۰ که در ۲۷ ژانویهی ۲۰۱۵ منتشر شد، http2 برای تعداد مشخصی از کاربران فعال شد. این تعداد در ابتدا بسیار کم و بهمرور زمان افزایش یافت.

پشتیبانی SPDY در کروم ۵۱ به خاطر http2 حذف شد. در یک پست بلاگ، این پروژه در فبریهی ۲۰۱۶ اعلام شد:

«بیش از ۲۵٪ منابع در کروم اکنون در بستر HTTP/2 کار میکنند، در مقایسه با کمتر از ۵٪ بر بستر SPDY. بر اساس چنین تأثیری، از ۱۵ می - سالروز انتشار HTTP/2 RFC - کروم دیگر از SPDY پشتیبانی نخواهد کرد.»

عبارت chrome://flags//#enable-spdy4 را در آدرسبار مرورگر خود وارد کنید و بر روی «enable» کلیک کنید، اگر قبلا فعال نشده است.

به یاد داشته باشید که Chrome از http2 تنها در بستر TLS پشتیبانی میکند، یعنی فقط سایتهایی که با https:// شروع میشوند.

افزونههایی برای Chrome وجود دارد که نشان میدهد که سایت از HTTP/2 استفاده میکند یا نه. یکی از آنها است.

آزمایشهای کنونی Chrome با QUIC مقداری آمارهای HTTP/2 را تغییر میدهند. قسمت ۱۲.۱ را برای اطلاعات بیشتر درمورد QUIC ببینید.

این نوشته به زبان سادهتری استاندارد HTTP/2 (RFC 7540), پیشزمینهی آن, مفاهیم, پرتکل، پیادهسازیهای انجامشده و آیندهی آن را توصیف میکند.

صفحهی https://daniel.haxx.se/http2/ را برای توضیحات جامعتر درمورد این پروژه ببینید.

همچنین، برای سورس این کتاب، صفحهی https://github.com/bagder/http2-explained را ببینید.

من از همهی کمکها و مشارکتکنندگان برای بهبود این پروژه استقبال میکنم! ما Pull Request هم قبول میکنیم، اما شما میتوانید برایمان در قسمت issues هم بنویسید یا اصلا به ایمیلم به آدرس [email protected] پیشنهادتان را بفرستید!

/ دنیل استِنبرگ

در این ترجمه سعی کردهام بدون استفاده از واژههای ناملموس و ناآشنا، ترجمهای روان و همهگیر ارائه دهم؛ همچنین در نیز واژهها و اصطلاحات جدیدتر را آوردهام.

این ترجمه، ترجمهای تحتاللفظی نیست که تکتک جملات در نوشتهی اصلی با جملات ترجمهشده یکسان باشند، اما تلاش کردم که مقصود اصلی نویسنده منتقل شود و محتوای نوشتهی اصلی حفظ شود.

قطعا این ترجمه بینقص نیست و جای بهترشدن دارد. خوشحال میشوم که پیشنهادات خودتان را در توئیتر به اکانت یا ایمیل the.black.suited در جیمیل بفرستید.

امیدوارم با خواندن این کتاب، چیزهای جدیدی یاد بگیرید (:

اگر فکر میکنید این نوشته، اطلاعات کافی درمورد موضوع ارائه نمیدهد، میتوانید از لینکهای زیر برای ارضای حس کنجکاو خود استفاده کنید:

لیست ایمیلی HTTPbis و آرشیو ایمیلهای آن: https://lists.w3.org/Archives/Public/ietf-http-wg/

مشخصات http2 در قالب HTML: https://httpwg.github.io/specs/rfc7540.html

جزئیات نحوهکار فایرفاکس با http2: https://wiki.mozilla.org/Networking/http2

جزئيات پیادهسازی http2 توسط curl:

وبسایت http2: و سؤالات متداول مربوط به پرتکل:

فصل HTTP/2 در کتاب “High Performance Browser Networking” ایلیا کریگورک:

HTTP 1.1 se ha convertido en un protocolo usado por prácticamente todo el mundo en Internet. Existen inversiones enormes realizadas en protocolos e infraestructura para aprovecharlo. Esto se ha interpretado cómo que a menudo es más fácil hacer funcionar algo sobre HTTP, que construir algo propiamente nuevo.

Cuando se creó HTTP y fue liberado al mundo, fue concebido como un protocolo más bien simple y sencillo, pero el tiempo ha demostrado lo contrario. HTTP 1.0 en el RFC 1945 es una especificación de 60 páginas publicada en 1996. El RFC 2616 que describe HTTP 1.1, fue publicado sólo tres años más tarde, en 1999 y creció considerablemente hasta las 176 páginas. Todavía, cuando desde el EIETF trabajamos en la actualización de la especificación que fue separada en seis documentos, con un número mucho mayor de páginas en total (resultando en el RFC 7230 y familia). De cualquier modo, HTTP 1.1 es grande e incluye una gran variedad de detalles y sutilezas, sin olvidar una gran cantidad de importantes piezas opcionales.

بهتر نیست که یک پرتکل بهتر بسازیم؟ پرتکلی که...

به تأخیرها کمتر حساس باشه

مشکل HTTP Pipelining رو و Head-of-line blocking رو حل کنه

نیازی به افزایش تعداد Host name نداشته باشه

Le a fourni un support http2 expérimental depuis septembre 2013.

Dans l'esprit curl, nous voulons supporter toutes les fonctionnalités http2 possibles. curl est souvent utilisé comme outil de test et nous voulons que ce soit le cas pour http2 également.

curl utilise une librairie distincte pour la couche http2. curl requiert nghttp2 1.0 ou plus.

Notez qu'actuellement, sous linux, curl et libcurl ne sont pas toujours délivrés avec le support du protocole HTTP/2 activé.

وقتی ما با مشکلات مواجه میشویم، گرد هم میآییم تا برای آنها راهحلهایی پیدا کنیم. بعضی از این راهحلها کاربردی و هوشمندانه هستند، و بعضی دیگر فقط باعث درستشدن موانع بیشتر میشوند.

Spriting روشی است که چندین عکس کوچکتر را در قالب یک عکس بزرگ جا میدهند. سپس، با جاوا اسکریپت یا CSS، میتوانید عکسهای کوچکتر را از این عکس بزرگ ببرید و آنها را نمایش دهید.

وبسایتها از این روش برای افزایش سرعت استفاده میکنند. دانلود یک عکس بزرگ از طریق HTTP 1.1، بسیار سریعتر از دریافت ۱۰۰ عکس کوچکتر است.

پرتکل http2 فرض میکند که گیرنده باید همهی فریمهای ناشناخته را بخواند و نادیده بگیرد (فریمهایی که نوع ناشناختهای دارند). دو طرف میتوانند نوع فریمهای جدیدی را تعیین کنند، اما این فریمها نمیتوانند وضعیت خود را تغییر دهند و جریان آنها کنترل نمیشوند.

موضوع این که آیا http2 اجازهی افزونهها را بدهد یا نه، در طول توسعهی پرتکل سر آن بحثهای زیادی انجام گرفت که توسعهدهندگان نظر خود را مرتبا عوض میکردند. بعد از پیشنویس ۱۲، در نهایت افزونهها در http2 مجاز شدند.

افزونهها جزئی از خود پرتکل نیستند و مستندات آنها در خارج از هستهی استانداردهای پرتکل قرار دارند. قبلا دو نوع فریم در پرتکل به عنوان افزونهها تعریف شده. آنها را اینجا به دلیل محبوبیت و اینکه قبلا جزئی از پرتکل بودند، توضیح میدهم.

با ورود http2، کانکشنهای TCP میتوانند به هر دلیلی، حجیمتر شوند و مدت برقراری آنها نسبت به کانکشنهای HTTP 1.x افزایش یابند. یک کلاینت باید بتواند این مشخصهها را در یک کانکشن افزایش دهد، و این کانکشن میتواند برای مدت نسبتا زیادی برقرار باشد.

Ceci est un document détaillé décrivant HTTP/2 (), les prémices, concepts, protocole, les implémentations existantes et ce que le futur pourrait nous réserver.

Référez-vous à pour tout ce qui concerne ce projet.

Référez-vous à pour le code source de ce livre.

J'encourage et apprécie l'aide et les contributions de chaque personne qui désire apporter des améliorations. Nous acceptons les , mais vous pouvez également simplement créer un ou encore envoyer un courriel à [email protected] avec vos suggestions!

این نوشته http2 را از یک نگرش تکنیکی و پرتکلی توصیف میکند. نوشتن آن، زمانی که آغاز شد که دنیل آن را به صورت یک ارائه در استکهلم در آپریل ۲۰۱۴ عرضه کرد که پس از آن، گسترش یافت و با توضیحات بیشتری به یک نوشته با جزئیات بیشتر تبدیل شد.

RFC 7540 نام رسمی مشخصات نهایی http2 است که در پانزدهم می ۲۰۱۵ منتشر شد:

تمامی خطاها در این نوشته، حاصل قصور من [یا مترجم] است. لطفا اگر خطایی دیدید، به من اطلاع دهید تا در نسخههای بعدی آنها را رفع کنم.

در این نوشته، به طور ثابت از واژهی http2 برای خطاب این پرتکل جدید استفاده کردهام، در حالی که از نظر فنی، نام صحیح آن HTTP/2 میباشد. من این تصمیم را برای بهبود خوانایی نوشته و تطابق آن با زبان گرفتهام.

この文書の内容または技術的詳細が薄いと考えるなら、あなたの好奇心を満足させる参考文献をここに紹介します:

HTTPbisメーリングリストとアーカイブ:

HTML化されたhttp2仕様書:

Firefoxのhttp2ネットワーキングに関する詳細:

L'équipe Chromium a implémenté http2 depuis un certain temps via les canaux beta et dev. Depuis Chrome 40, sorti le 27 janvier 2015, http2 est activé par défaut pour un certain nombre d'utilisateurs. Ce nombre a commencé petit pour devenir important au fil du temps.

Le support SPDY sera retiré. Dans un blog, il est annoncé en :

“Chrome supporte SPDY depuis Chrome 6, mais comme les bénéfices sont présents dans HTTP/2, il est temps de lui dire au revoir. Le support SPDY sera retiré début 2016.”

Este es un documento detallado que describe HTTP/2 (), sus antecedentes, conceptos, el protocolo y algo sobre las implementaciones existentes y lo que nos puede deparar el futuro.

El sitio es el home canónico de este proyecto.

En se encuentra el código fuente de todo el contenido del libro.

Se alienta y da la bienvenida a cualquier ayuda o contribución de cualquiera que quiera ofrecer mejoras. Aceptamos , aunque también puedes rellenar o enviar un correo a [email protected] con tus sugerencias.

発想とパッケージのフォーマットのレゴ画像は、Mark Nottingham氏から。

HTTPトレンドデータは から。

RTTのグラフはMike Belshe氏のプレゼンテーションから。

ヘッドオブラインの絵を作成するためにレゴのおもちゃを私に貸してくれた私の子供たちAgnesとRexに。

レビューとフィードバックをくれた友人たちに: Kjell Ericson、Bjorn Reese、Linus Swälas and Anthony Bryanに。あなたの助けには非常に感謝しています。お陰で文書がすばらしくよくなりました。

執筆中にいろいろな段階で、バグレポートや文書の改善に協力してくれた友人たちに: Mikael Olsson、Remi Gacogne、Benjamin Kircher、saivlis、florin-andrei-tp、Brett Anthoine、Nick Parlante、Matthew King、Nicolas Peels、Jon Forrest、sbrickey、Marcin Olak、Gary Rowe、Ben Frain、Mats Linander、Raul Siles、Alex Lee、Richard Moore

Firefox ha estado siguiendo la pista a los borradores muy de cerca, y ofreciendo implementaciones http2 de prueba durante muchos meses. Durante el desarrollo del protocolo http2, los clientes y servidores tienen que ponerse de acuerdo sobre que versión del borrados están utilizando, lo cual dificulta levemente ejecutar pruebas. Hay que asegurarse de que el cliente y el servidor implementan la misma versión del borrador del protocolo.

Desde la versión 35, publicada el 13 de enero de 2015, Firefox soporta http2 por defecto.

Entrar en 'about:config' en la barra de direcciones, y buscar la opción denominada “network.http.spdy.enabled.http2draft”. Habrá que asegurarse qu está puesta a true. Firefox 36 añadió otra opción de configuración llamada “network.http.spdy.enabled.http2” que está a true por defecto. Ésta última controla la versión simple de http2, mientras que la primera activa y desactiva la negociación de la revisiones de los borradores de http2. Ambas opciones están actividad desde Firefox 36.

فایرفاکس، پیشنویسهای مربوط به http2 را از نزدیک دنبال میکرده و تستهای مربوط به پیادهسازیها را ماهها قبل ارائه داده است. در هنگام توسعهی http2، کلاینتها و سرورها باید بر یک نسخهی پیشنویس توافق میکردند که اجرای آزمایشها را مقداری آزاردهنده میکرد. آگاه باشید که کلاینت و سرور بر روی کدام پیشنویس پرتکل پیادهسازیشده توافق میکنند.

در فایرفاکس ۳۵ و بالاتر که در ۱۳ ژانویهی ۲۰۱۵ منتشر شد، پشتیبانی از http2 به طور پیشفرض فعال است.

در آدرسبار مرورگر عبارت about:config را وارد کنید و به دنبال گزینهای به نام network.http.spdy.enabled.http2draft

Chromiumチームはhttp2を実装していて、長い間dev、betaチャンネルでそのサポートを行っています。2015年1月27日にリリースされたChrome 40から、一部のユーザーにおいてhttp2がデフォルトで有効になりました。その数は最初は少なく設定されていましたが、時とともに徐々に増加しました。

SPDYサポートは削除される予定です。のブログでの発表によると:

”ChromeはSPDYをChrome 6からサポートしてきました。しかしそのほとんどの恩恵はHTTP/2からも得られることから、さようならをすることに決めました。SPDYを2016年の早い時期に削除する予定です。”

ブラウザーのアドレスバーに”chrome://flags/#enable-spdy4”と入力し、まだ有効になっていない場合は、”enable”をクリックします。

多くの困難な決断と妥協がhttp2ではなされました。http2がデプロイされれば、次のプロトコルリビジョンへのアップグレードのための基礎になります。また異なる複数のバージョンを同時に処理できる概念やインフラストラクチャーをもたらします。おそらく新しいものを導入するときに古いものをすべて捨て去る必要がなくなることでしょう。

http2は、HTTP 1とhttp2間の通信をプロキシーできるようにしたいという願望のためHTTP 1の”遺産”の多くを引き継いでいます。遺産の中のいくつかはさらなる発展や発明を妨げます。もしかするとHTTP 3ではそれらを捨て去ることになるかもしれませんね。

あなたがHTTPで足りないと思っていることはありますか?

Googleの(Quick UDP Internet Connections)は興味深い実験です。それはSPDYのときと同じようなスタイルと精神で行われています。QUICはTCP + TLS + HTTP/2の代替品でありUDPを使って実装されます。

Se han tomado muchas decisiones duras y compromisos en http2. Con el despliegue de http2 por delante, se ha determinado una forma para actualizar a otras versiones, que sienta las bases para tener nuevas revisiones del protocolo más adelante. Se ha introducido el concepto y la infraestructura necesarias para manejar múltiples versiones en paralelo. ¿Quizás no es necesario descontinuar completamente lo viejo para introducir algo nuevo?

http2 lleva al futuro un montón de “legado” HTTP 1 con la intención de mantener posible tráfico de proxy de ida y vuelta entre HTTP 1 y http2. Parte de ese legado dificulta aún más el desarrollo y la inventiva. ¿Quizás http3 se deshará de parte de este legado?

¿Qué crees que falta todavía en http?

Mark Nottingham per l'ispirazione e l'immagine formato Lego dei pacchetti.

I dati sui trend HTTP provenienti da .

I grafici RTT provengono dalle presentazioni di Mike Belshe.

I miei figli Agnes e Rex per avermi prestato i loro personaggi Lego per l'immagine "inizio della fila".

Grazie agli amici per riletture e ritorni: Kjell Ericson, Bjorn Reese, Linus Swälas e Anthony Bryan. Il vostro aiuto è immensamente apprezzato e ha davvero migliorato questo documento!

Nel corso delle varie iterazioni, le persone seguenti hanno amicalmente inviato bug-report e migliorie a questo documento: Mikael Olsson, Remi Gacogne, Benjamin Kircher, saivlis, florin-andrei-tp, Brett Anthoine, Nick Parlante, Matthew King, Nicolas Peels, Jon Forrest, sbrickey, Marcin Olak, Gary Rowe, Ben Frain, Mats Linander, Raul Siles, Alex Lee, Richard Moore

この文書はHTTP/2()、その背景、コンセプト、プロトコル、既存の実装および未来がどうなるかを記述したものです。

このプロジェクトのサイトは を見てください。

文書の全ソースコードは を見てください。

改善案をお持ちの方はだれでも大歓迎です。私達はを受け付けていますが、[email protected] まで改善案をメールで送って頂いても結構です。

/ Daniel Stenberg

Il team di Chromium ha implementato http2 e ha anche fornito supporto sui canali dev e beta per lungo tempo. A partire da Chrome 40, rilasciato il 27 Gennaio 2015, http2 è abilitato per default per un determinato numero di utenti. Hanno iniziato supportando una utenza ristretta per poi aumentare gradualmente nel tempo.

Il supporto nativo per SPDY verrà eventualmente eliminato. Il progetto ha comunicato tale notizia in un post :

“Chrome ha supportato SPDY a partire dalla versione 6, ma dato che la maggior parte dei benefici sono presenti anche in HTTP/2, è tempo di dirsi addio. Pianifichiamo di rimuovere il supporto per SPDY ad inizio 2016”

Le protocole oblige le destinataire à lire et ignorer toutes les trames inconnues utilisant un type de trame inconnu. Les deux parties peuvent ainsi négocier l'utilisation d'un nouveau type de trame de manière unitaire; ces trames ne seront pas autorisées à changer d'état et ne bénéficieront pas de contrôle de flux.

Le fait d'autoriser ou non les extensions dans http2 a été débattu pendant le développement du protocole avec des opinions pour et contre. Depuis le draft-12, la balance a penché en faveur du pour: les extensions sont autorisées.

Les extensions ne font pas partie du protocole actuel mais seront documentées en dehors de la spécification principale. En l'état, il existe deux types de trames qui pouvaient faire partie du protocole et qui seront probablement les premières trames définies comme extensions. Je les décris ici car elles sont populaires et étaient considérées auparavant comme des trames "natives":

از همین تعاملها، محتوا و ساختارهای URI پشتیبانی کنه

و توسط کارگروه HTTPbis در IETF ساخته شده باشه!

IETF یک سازمان برای توسعه و ترویج استانداردهای اینترنت در سطح پرتکل است. این سازمان بیشتر به خاطر سری استانداردهای RFC شامل TCP، DNS، FTP و از همه بهتر HTTP و یکسری پرتکلهای دیگر که هیچجا شناخته نشدهاند، مشهور است.

در IETF، کارگروههای اختصاصی با اختیارات محدود برای رسیدن به یک هدف مشخص کار میکنند. آنها یک منشور مشخص میکنند تا خطمشیها و محدودیتها برای چیزی که تولید میکنند را مشخص کنند. همهی افراد اجازهی مشارکت در بحث و توسعه را دارند. هر کسی که شرکت میکند و چیزی میگوید، گفتهی او، اهمیت یکسانی نسبت به گفتههای دیگران دارد و هر کسی به عنوان یک فرد مستقل شناخته میشود، بدون درنظرگرفتن شرکتی که او در آنجا کار میکند.

کارگروه HTTPbis در تابستان ۲۰۰۷ شکل گرفت و وظیفه دارد تا استانداردهای HTTP را آپدیت کند. در این گروه، بحث درمورد نسخهی بعدی HTTP در اواخر سال ۲۰۱۲ شکل گرفت. کار آپدیت HTTP 1.1 در اوایل ۲۰۱۴ تمام شد که نتیجهی آن را در سری RFC 7230 میبینید.

آخرین نشست فنی کارگروه HTTPbis در ژوئن ۲۰۱۴ در شهر نیویورک برگزار شد. بحثهای باقیمانده و روند رسمی IETF انجام شدند تا این استاندارد RFC به طور رسمی سال بعد عرضه شود.

بازیگران بزرگتر در عرصهی HTTP در جلسات و گفتگوهای این کارگروه غایب بودند. نمیخواهم نام هیچ شرکت یا محصول خاصی را ببرم، اما واضح است که بعضی از بازیگران اصلی اینترنت امروز، مطمئن هستند که IETF بدون آنها هم عملکرد خوبی خواهد داشت...

نام گروه HTTPbis است که پسوند bis از در لاتین به معنای دو است. پسوند Bis معمولا در IETF برای هر آپدیت یا نسخهی دوم هر چیزی استفاده میشود؛ مثلا همین بهروزرسانی HTTP 1.1.

SPDY یک پرتکل است که توسط گوگل توسعه داده و توزیع شد. آنها، این پرتکل را در یک محیط باز توسعه دادند و از همگان دعوت کردند که شرکت کنند ولی روشن است که آنها با کنترلکردن پیادهسازی یک مرورگر پرطرفدار و همچنین سرورهای پرجمعیتی که از سرویسها استفاده میکردند، سود میبردند.

هنگامی که گروه HTTPbis تمصمیم گرفت که روی http2 کار کند، SPDY قبلا ثابت کرده بود که یک طرح عملی است. SPDY نشان داده بود که استفاده از آن در اینترنت ممکن است و آماری هم وجود دارد که تا چه حد خوب کار میکند. کار http2 با پیشنویس SPDY/3 شروع شد که به سادگی، تبدیل به پیشنویس صفر (draft-00) HTTP2 با کمی تغییر شد.

این موضوع روی چگونگی کار Load Balancerهای HTTP تأثیر میگذارد و ممکن است موجب شرایطی شود که یک سایت به کلاینت پیشنهاد دهد که به یک سرور دیگر متصل شود. ممکن است دلیل این کار، افزایش سرعت و کارایی باشد، یا سرور تحت تعمیر باشد و سرور دیگری دردسترس باشد و غیره.

سرور میتواند هدر Alt-Svc (یا فریم ALTSVC) را به کلاینت بفرستد که سرویس دیگری موجود است: یک مسیر دیگر به همان محتوا، در یک سرور دیگر، میزبان دیگر و پورت دیگر.

کلاینت باید به آن سرویس دیگر به طور ناهمگام وصل شود و فقط در صورتی از جایگزین استفاده کند که کانکشن جدید موفق باشد.

هدر Alt-Svc به سرور اجازه میدهد که محتوا را بر پرتکل http:// ارائه دهد تا به کلاینت اطلاع دهد که همان محتوا روی یک کانکشن امن TLS هم دردسترس هستند.

این قابلیت کمی شکبرانگیز است. این نوع کانکشن میتواند TLS احرازنشده انجام دهد و دیگر نتواند امن معرفی شود، هیچ علامت قفلی در UI نشان داده میشود و در واقع هیچ راهی وجود ندارد که به کاربر بگوییم که این همان HTTP ساده و قدیمی است، ولی همچنان این TLS فرصتگراست و بعضی از افراد شدیدا مخالف این مفهوم هستند.

این نوع فریم وقتی ارسال میشود که یکی از طرفین کانکشن http2 دادهای را ارسال میکند، اما کنترل جریان اجازهی ارسال را نمیدهد. ایده این است که اگر کلاینت یا سرور این فریم را دریافت کند، شما میدانید که یک جای کار مشکل دارد و یا سرعت انتقال کمتر است.

متن زیر قسمتی از پیشنویس ۱۲ است، قبل از این که این نوع فریم، افزونه شود.

«فریم BLOCKED در این پیشنویس گنجانده شده تا آزمایشها را تسهیل کند. اگر نتایج آزمایشها، بازخورد مثبتی نداشته باشد، ممکن است حذف شود.»

ترجمهی مفهومی آن: «مسدودسازی توسط نفر اول یک صف». متأسفانه هیچ ترجمهی دیگری برای این اصطلاح پیدا نکردم.

به نامهایی که به هر میزبان اختصاص میدهند گفته میشود. مثلا localhost، google.com، wikipedia.org و m.wikipedia.org هر کدام یک Host name مستقل هستند.

Cookies به دادههای کوچکی گفته میشود که در مرورگرها به درخواست سرور ذخیره میشوند و در هر درخواست، همراه با اطلاعات دیگر به سرور فرستاده میشوند.

Internet Enginnering Task Force نیروی کار مهندسی اینترنت

Transport Layer Security یکی از پروتکلهای رمزنگاری است و برای تأمین امنیت ارتباطات از طریق اینترنت بنا شدهاست.

Next Protocol Negotiation ارتباط اولیهی پرتکول بعدی

Application Layer Protocol Negotiation ارتباطاولیهی لایهی کاربری پرتکول

Avec http2 adopté, on peut suspecter que les connexions TCP seront plus longues (en temps) et maintenues actives plus longtemps que les connexions HTTP 1.x. Un client doit donc pouvoir se débrouiller avec une seule connexion par hôte/site et cette connexion pourrait rester ouverte pendant un certain temps.

Cela affectera comment les load balancers HTTP réagissent quand un site voudra que les utilisateurs se connectent sur un autre host, pour des raisons de performance ou pour réaliser une maintenance.

Le serveur enverra alors l'en-tête Alt-Svc: (ou la trame http2 ALTSVC) pour indiquer au client un service alternatif. Une autre route pour le même contenu, utilisant un autre service, host et numéro de port.

Un client est alors susceptible d'essayer de se connecter à ce service de manière asynchrone et n'utiliser que celui-ci s'il fonctionne.

L'en-tête Alt-Svc permet à un serveur servant du contenu en http:// d'informer le client que le même contenu est aussi disponible en TLS.

Cette fonctionnalité est débattue. Cette connexion serait du TLS non authentifié et ne serait pas affichée comme "sécurisée", n'utiliserait pas de cadenas dans l'interface graphique du navigateur même si ce n'est pas du simple HTTP. Plusieurs personnes sont contre.

Ce type de trame doit être envoyée une seule fois par un client http2 quand des données doivent être envoyées alors que le contrôle de flux l'interdit. L'idée est que si votre implémentation reçoit une telle trame, cela vous indique que quelque chose cloche dans votre implémentation et que vous avez une performance suboptimale.

Une citation du draft-12, avant que cette trame ne soit retirée pour devenir une extension:

“La trame BLOCKED est incluse dans ce draft pour en faciliter son expérimentation. Si les resultats de cette expérimentation ne donnent pas de feedback positif, elle pourra être retirée”

curl supporte http2 sur TCP via l'en-tête Upgrade:. Si vous initiez une requête HTTP en demandant HTTP 2, curl demandera au serveur de mettre à niveau (Upgrader) sa connexion en http2.

curl supporte différentes librairies TLS et c'est toujours valide pour http2. La difficulté avec TLS et http2 est le support de ALPN et potentiellement NPN.

Compilez curl avec des versions récentes d'OpenSSL ou NSS pour avoir ALPN et NPN. Avec GnuTLS et PolarSSL vous n'aurez que ALPN et pas NPN.

Pour indiquer à curl d'utiliser http2, en clair ou TLS, utilisez l'option --http2 ("tiret tiret http2"). curl utilise HTTP/1.1 par défaut, d'où cette option nécessaire pour http2.

Votre application utilisera http:// ou https:// comme d'habitude, mais vous pouvez régler la variable curl_easy_setopt de CURLOPT_HTTP_VERSION vers CURL_HTTP_VERSION_2 pour que libcurl tente d'utiliser http2. Il le fera en best effort sinon utilisera HTTP 1.1.

Etant donné que libcurl essaye de maintenir ses anciens comportements dans la mesure du possible, vous devez activer le multiplexage HTTP/2 pour votre application via l'option CURLMOPT_PIPELINING. Sinon elle continuera à utiliser une requête à la fois par connexion.

Un autre détail à garder à l'esprit et que si vous demandez plusieurs transferts en simultanés à libcurl, en utilisant son interface multi, une application peut très bien commencer autant de transfert que voulu, et que si vous préférez que libcurl attende un peu pour les placer tous sur la même connexion, plutôt que d'ouvrir une connexion pour chacun, utilisez l'option CURLOPT_PIPEWAIT pour chaque transfert que vous préférez attendre.

libcurl 7.44.0 et plus supporte le server push de HTTP/2. Vous pouvez tirez des avantages de cette fonctionnalité en configurant un callback de push avec l'option CURLMOPT_PUSHFUNCTION. Si le push est accepté par l'application, il créera un nouveau transfert en tant que CURL easy handle et l'utilisera pour délivrer le contenu, comme tout autre transfert.

/ Daniel Stenberg

curlのhttp2実装に関する詳細: https://curl.haxx.se/docs/http2.html

http2 webサイト: https://http2.github.io/ and perhaps in particular the FAQ: https://http2.github.io/faq/

Ilya Grigorikの著書”High Performance Browser Networking”のHTTP/2の章: https://hpbn.co/http2/

Souvenez-vous que Chrome n'implémente http2 que sur TLS. Vous ne verrez du http2 que si vous allez sur les sites https:// qui offrent http2.

Il existe des plug-ins Chrome permettant de visualiser si un site utilise http2. En voici un: “SPDY Indicator”.

Les tests QUIC en cours masquent un peu les résultats HTTP/2. (voir chapitre 12.1)

/ Daniel Stenberg

개선 사항을 가지고 계신분은 누구나 환영합니다. 우리는 pull requests 를 받고 있지만, [email protected] 로 여러분의 제안을 메일로 보내주셔도 괜찮습니다

/ Daniel Stenberg

Chromeはhttp2をTLS上でのみ実装することを忘れないでください。Chromeではhttps://のhttp2をサポートするサイトでのみhttp2は動作します。

サイトがhttp2を使用しているかどうかの可視化を手伝いするChromeプラグインがあります。それらの一つは”HTTP/2 and SPDY Indicator”です。

現在行われているChromeによるQUIC(12.1を参照)の試験が、HTTP/2の使用率を幾分下げています。

QUICは現時点ではGoogleによってChromeとGoogleサーバーにだけ実装されています。コードは簡単に再利用できる形にはなっていません。libquicというプロジェクトがそれを実現しようとしています。プロトコルはドラフトとしてIETFトランスポートワーキンググループへ提出されました。

Digitare “chrome://flags/#enable-spdy4" nella barra indirizzi e cliccare su “enable” se non fosse gia abilitato.

Ricordate che Chrome implementa http2 solo attraverso TLS. Vedrete http2 in azione solamente quando Chrome verrà utilizzato su un sito https:// che offra supporto nativo http2.

Sono disponibili plugin per Chrome che aiutano a visualizzare se un sito stia utilizzando HTTP/2. Uno di questi è “HTTP/2 and SPDY Indicator”.

Gli attuali esperimenti di Chrome e l'impiego di QUIC (vedi sezione 12.1) fanno sì che il numero di connessioni HTTP/2 sia in diminuzione.

http2 چه فایدهای دارد؟ مرزهای تعیینشده برای کارگروه HTTPbis چه هستند؟

این مرزها در واقع بسیار محدود بودند و اختیارات کمی به گروه برای نوآوری میدادند:

http2 باید از پارادایمهای HTTP پشتیبانی کند. یعنی همچنان پرتکلی است که کلاینت از طریق TCP به سرور درخواستی میفرستند.

پیشوندهای http:// و https:// نباید تغییر کنند. هیچ پیشوند تازهای نمیتوان ایجاد کرد. محتوایی که تحت این پیشوندها دردسترس هستند، بیشتر از آن هستند که بتوان تغییرشان داد.

سرورها و کلاینتهای HTTP1 تا دههها وجود خواهند داشت، پس باید بتوان آنها را با سرورهای http2 پراکسی کرد.

تبعا، پراکسیها باید بتوانند قابلیتهای http2 را به کلاینتهای HTTP 1.1، یکبهیک مربوط کنند.

حذف یا کاهش قسمتهای اختیاری پرتکل. این کار واقعا لازم نبود، در واقع یک حرکت بود که از گوگل و SPDY شروع شد. وقتی مطمئن باشیم که همهچیز ضروری هستند، میتوانید بدون اینکه چیزی جا بیندازید، آن را پیادهسازی کنید که بعدا گرفتار نشوید.

نسخههای جزئی نداشته باشیم. ما تصمیم گرفتیم که کلاینتها یا سرورها یا با http2 سازگارند یا نیستند. اگر نیاز به توسعهی پرتکل وجود داشت، نسخهی بعدی، http3 خواهد بود. هیچ نسخهی جزئی (Minor) در http2 نخواهیم داشت.

همانطور که قبلا هم اشاره شد، پیشوندها و ساختارهای کنونی URI را نمیتوان تغییر داد، پس http2 باید از آنهایی که الان هستند استفاده کند. از آنجایی آنها در HTTP 1.x استفاده میشوند، به یک راه نیاز داریم که پرتکل را به http2 ارتقا دهیم یا از سرور بخواهیم که از http2 به جای پرتکلهای قدیمی استفاده کند.

HTTP 1.1 قبلا یک راه برای این منظور تعریف کرده: استفاده از هدر Upgrade: که به سرور اجازه میدهد که پاسخ درخواست را با پرتکل جدید بدهد، که هزینهی این کار، پذیرش دو درخواست به جای یکی است.

این دوبرابر شدن درخواستها، چیزی نبود که تیم SPDY بتواند قبول کند، و از آنجایی که آنها SPDY را تنها بر روی TLS پیاده کرده بودند، یک افزونه برای TLS توسعه دادند که ارتباط اولیه (Negotiation) را به طور چشمگیری سریعتر و کوتاهتر میکرد. با این افزونه، که NPN نام دارد، سرور به کلاینت اطلاع می دهد که چه پرتکلهایی را میشناسد و کلاینت میتواند از پرتکلی که ترجیح میدهد استفاده کند.

تلاشهای زیادی انجام شده که http2 بر TLS به درستی رفتار کند. SPDY به TLS نیاز دارد و این تصمیم مهمی بود که TLS را برای الزامی کنیم، ولی به یک نتیجهی جمعی نرسیدیم، بنابراین http2 با TLS به صورت اختیاری منتشر شد. با این حال، دو پیادهسازی برجسته اعلام کردند که http2 تنها از طریق TLS دردسترس خواهد بود: فایرفاکس از موزیلا و کروم از گوگل، دو مرورگر پیشروی امروز.

دلایل اجباریکردن TLS، احترام به حریمخصوصی کاربر است، همچنین آزمایشهای اولیه نشان داد که پرتکلهای جدید، میزان موفقیت بیشتری دارند، اگر بر مبنای TLS باشند. این به اینخاطر است که معمولا فرض بر این گذاشته میشود که ترافیکی که از پورت ۸۰ عبور میکند، با پرتکل HTTP 1.1 کار میکند. وقتی پرتکلهای دیگری از این پورت استفاده میکنند، بعضی از واسطهها (مثلا آنتیویروسها) ممکن است اختلال ایجاد کنند یا حتی دادههای رسیده را از بین ببرند.

موضوع اجباریشدن TLS مناقاشات زیادی را در لیستهای ایمیل و دیدارها بهوجود آورد - آیا این کار درست است یا غلط؟ موضوعی که بسیار جدالآمیز است - مواظب باشید که آن را ناگهانی از یکی از اعضای کارگروه HTTPbis نپرسید!

به طور مشابه، بحثی هم درمورد این وجود داشته که آیا http2 باید لیستی از روشهای رمزنگاری را برای TLS اجباری کند، یا لیستسیاهی از این الگوریتمها درست کند، یا شاید هیچکاری به لایهی TLS نداشته باشد و اجازه دهد که کارگروه TLS کار خودشان را انجام دهند. نتیجه آن شد که استاندارد تعیین کرد که نسخهی TLS باید حداقل ۱.۲ باشد و همچنین در انتخاب روشهای رمزنگاری (Cipher Suite) نیز محدودیتهایی وجود دارد.

NPN پرتکلی بود که SPDY برای مذاکره یا همان ارتباط اولیه با سرورهای TLS استفاده میکرد. از آنجایی که این پرتکل استاندارد نبود، NPN از IETF گذشت و نتیجه شد: ALPN. ALPN در حالحاضر برای http2 استفاده میشود، در حالی که کلاینتها و سرورهای SPDY هنوز از NPN استفاده میکنند.

در حقیقت، NPN اول وجود داشته و در زمانی که ALPN در فرآیند استانداردسازی قرار داشته، کلاینتها و سرورهای http2 بسیاری بهوجودآمدند که از هردوی آنها پشتیبانی میکردند. همچنین، از NPN در SPDY استفاده میشود و سرورهای بسیاری SPDY و http2 ارائه میدهند. پس پشتیبانی همزمان از NPN و ALPN در این سرورها، کاملا منطقی است.

ALPN با NPN تفاوتشان در در این است که چه کسی تصمیم میگیرد که با چه پرتکلی صحبت کند. در ALPN، کلاینت لیستی از پرتکلهایی که پشتیبانی میکند را به سرور میدهد و سرور برحسب کارایی و اولویت، یکی را انتخاب میکند، در حالی که در NPN، کلاینت تصمیم نهایی را میگیرد.

همانطور که قبلا اشاره کردم، برای HTTP 1.1 که از متن ساده (plain text) استفاده میکند، ارتباط اولیهی http2 با هدر Upgrade: انجام میشود. اگر سرور به http2 صحبت میکند، با کد "101 Switching" پاسخ میدهد و پس از آن، با کلاینت http2 صحبت میکند. البته، این فرآیند، باعث دوبرابرشدن درخواستها و پاسخها میشود، ولی مزیت آن این است که معمولا ممکن است یک کانکشن http2 را مدت بیشتری زنده نگه داشت و از آن استفاده بیشتری نسبت به یک کانکشن HTTP1 کرد.

در حالی که بعضی از سخنگوهای مرورگرها اعلام کردند این مورد را پیادهسازی میکنند، تیم Internet Explorer یکبار اعلام کردند که این کار را میکنند، هر چند تا به الان به قول خود عمل نکردند. همچنین curl و چند کلاینت دیگر که مرورگر نیستند اعلام کردند که از http2 به صورت متنساده (clear-text/رمزنگارینشده) پشتیبانی میکنند.

امروزه، هیچ مرورگری بدون TLS از http2 پشتیبانی نمیکند.

QUIC permite la creación de conexiones con mucha menos latencia, soluciona la pérdida de paquetes al sólo bloquear flujos individuales en lugar de todos a la vez como hacer HTTP/2, y posibilita la creación de conexiones por distintas interfaces de red fácilmente – así también cubre otras áreas que MPTCP pretende resolver.

QUIC de momento está únicamente implementado por Google en Chrome y en sus servidores, y es código no fácilmente reutilizable en otras partes, aunque libquic es un esfuerzo intentado conseguir eso exactamente. La especificación es todavía algo vaga y cambia rápidamente. Ya existe un borrador en el grupo de trabajo de transporte del IETF.